S.L. Sobolev, A.I. Kitov y A.A. Lyapunov

El primer artículo positivo sobre cibernética en la URSS Revista Cuestiones de Filosofía nº 4, agosto, 1955 Informes y publicaciones científicas. Extraído de: https://www.computer-museum.ru/books/cybernetics.htm.

Para la elaboración de este documento se han tenido en cuenta los debates sobre los trabajos de cibernética realizados por los autores en el Instituto de Ingeniería Energética de la Academia de Ciencias de la URSS, en el Taller de Matemáticas de Máquinas de la Facultad de Mecánica y Matemáticas y en el Departamento de Biología de la Universidad de Moscú, en el Instituto Matemático Steklov, en el Instituto de Mecánica de Precisión e Ingeniería Informática de la Academia de Ciencias de la URSS, así como las observaciones del profesor S. A. Yanovskiy, del profesor A. A. Feldbaum, de S. A. Yablonov, de M. M. Bakhmetyev, de I. A. Poletaev y de M. G. G. Galinaev. S. A. Yanovskaya, Prof. A. A. Feldbaum, S. A. Yablonsky, M. M. Bakhmetyev, I. A. Poletaev, M. G. Gaase-Rapoport, L. V. Krushinsky, O. V. Lupanov, y otros. Aprovechamos la ocasión para expresar nuestro agradecimiento a todos los que participaron en el debate.

1. La importancia científica general de la cibernética

La cibernética es un nuevo campo científico que ha surgido en los últimos años y es un conjunto de teorías, hipótesis y puntos de vista relacionados con cuestiones generales de control y comunicación en máquinas automáticas y organismos vivos.

Esta área de la ciencia se está desarrollando rápidamente y aún no constituye una disciplina científica suficientemente coherente y operativa. En la actualidad, se han desarrollado tres ramas principales dentro de la cibernética, cada una de ellas de gran importancia por derecho propio:

- La teoría de la información, básicamente la teoría estadística del procesamiento y la transmisión de mensajes.

- La teoría de las máquinas de computación electrónicas rápidas y automáticas como teoría de los procesos lógicos autoorganizados similares a los procesos del pensamiento humano.

- Teoría de los sistemas de control automático, principalmente teoría de la retroalimentación, que involucra el estudio de los procesos del sistema nervioso, órganos sensoriales y otros órganos de los seres vivos desde un punto de vista funcional.

El aparato matemático de la cibernética es muy amplio: incluye, por ejemplo, la teoría de la probabilidad, en particular la teoría de los procesos aleatorios, el análisis funcional, la teoría de las funciones y la lógica matemática.

Un lugar importante en la cibernética lo ocupa el concepto de información. La información es un dato sobre los resultados de los acontecimientos que no se conocían de antemano. Lo esencial es que el dato recibido sea siempre una de un cierto número de posibles variantes del mensaje.

La cibernética imbuye a la noción de información un significado muy amplio, que incluye tanto todo tipo de datos externos que pueden ser percibidos o transmitidos por cualquier sistema concreto, como los datos que pueden producirse dentro del sistema. En este último caso, el sistema sirve como la fuente de los mensajes.

La información puede ser, por ejemplo, los efectos del entorno exterior sobre el un organismo animal o humano; los conocimientos e información adquiridos por el ser humano a través del aprendizaje; los mensajes destinados a ser transmitidos a través de una línea de comunicación; los datos brutos intermedios y finales en las máquinas de computación, etc.

Recientemente ha surgido una nueva perspectiva a partir del estudio de los procesos en los dispositivos automáticos. Y esto no es casualidad. Los dispositivos automáticos son lo suficientemente sencillos como para no oscurecer la esencia de los procesos por la abundancia de detalles y, por otra parte, la propia naturaleza de las funciones que desempeñan exige un nuevo enfoque. Mientras que la característica energética de su trabajo es, por supuesto, importante por sí misma, no toca en absoluto la esencia de las funciones que desempeñan. Para entender la esencia de su trabajo, es necesario, en primer lugar, fundamentar nuestra comprensión del concepto de información (datos) sobre el movimiento de los objetos.

Del mismo modo que la introducción del concepto de energía permitió considerar todos los fenómenos de la naturaleza desde punto de vista unificado y rechazar una serie de teorías falsas (la teoría del flogisto, los móviles perpetuos, etc.), la introducción del concepto de información, una medida única de la cantidad de información, permite abordar el estudio de diversos procesos de interacción de los cuerpos en la naturaleza desde un único punto de vista común.

Al considerar la información transmitida por un impacto, hay que subrayar que su carácter depende tanto del impacto como del cuerpo que lo percibe. En general, el impacto de la fuente sobre cuerpo afectado no se produce directamente, sino a través de una serie de impactos parciales que median esta relación. (El conjunto de medios por los que el impacto llega al cuerpo afectado se denomina canal de transmisión de información o, más breve, canal de comunicación).

Lo común a todos los tipos de información es que la información o los mensajes se dan siempre en alguna forma de secuencia temporal, es decir, en función del tiempo.

La cantidad de información transmitida, y más aún el efecto de la información en el receptor, no está determinada por la cantidad de energía gastada en la transmisión de la información. Por ejemplo, una conversación telefónica puede servir para detener una fábrica, llamar a los bomberos o felicitar a alguien en fiestas. Los impulsos nerviosos que van de los sentidos al cerebro pueden llevar consigo sensaciones de calor o frío, de placer o de peligro.

La esencia del principio de control es que el movimiento y la acción de grandes cantidades de, o la transmisión y transformación de grandes cantidades de energía son guiados y controlados por pequeñas cantidades de energía portadora de información. Este principio de control subyace en la organización y funcionamiento de cualquier sistema controlado: máquinas automáticas u organismos vivos. Por tanto, la teoría de la información, que estudia las leyes de transmisión y transformación de la información (señales), es la base de la cibernética, que estudia los principios generales del control y la comunicación en las máquinas automáticas y los organismos vivos. Todo sistema controlado automáticamente consta de dos partes principales: el objeto controlado y el sistema de control (controlador), y se caracteriza por la presencia de una cadena cerrada de información (Fig. 1).

Desde el controlador hasta el objeto, la información se transmite en forma de señales de control; en el objeto controlado, grandes cantidades de energía (en relación con la energía de las señales) se convierten en trabajo bajo la influencia de las señales de control. El circuito de información se cierra con las señales de retroalimentación, que son informaciones sobre el estado real del objeto controlado que vienen del objeto al controlador. El objetivo de cualquier controlador es convertir la información que describe el estado real del objeto en información de control, es decir, en información que debe determinar el comportamiento futuro del objeto. Un controlador es, por tanto, un dispositivo de transformación de la información. Las leyes de conversión de la información vienen determinadas por los principios de funcionamiento y el diseño del controlador.

En el caso más sencillo, un controlador puede ser simplemente un inversor lineal en el que la señal de retroalimentación que indica la desviación del objeto controlado de la posición deseada —la señal de error— se convierte linealmente en una señal de control. Los ejemplos más complejos de sistemas controlados son los sistemas nerviosos de los animales y los humanos. El principio de retroalimentación también es esencial para estos sistemas. Cuando se realiza una acción, las señales de control se transmiten en forma de impulsos nerviosos desde el cerebro hasta el órgano de control final y finalmente provocan el movimiento muscular. La línea de retroalimentación está representada por las señales sensoriales y las señales quinestésicas de posición de los músculos que se transfieren al cerebro y que describen la posición real de los actuadores.

Se ha establecido (véase P. Gulyaev «What is biophysics», “Science and Life” No 1, 1955) que los procesos que tienen lugar en los circuitos cerrados de retroalimentación de los organismos vivos pueden describirse matemáticamente y se aproximan a los procesos que tienen lugar en los complejos sistemas no lineales de regulación automática de dispositivos mecánicos en cuanto a sus características.

Además de los numerosos y complejos bucles cerrados de retroalimentación necesarios para que los organismos se muevan y actúen en el mundo exterior, todo organismo vivo tiene un gran número de complejos y diversos bucles de retroalimentación internos diseñados para mantener las condiciones normales de un organismo (regulación de la temperatura, composición química, presión sanguínea, etc.). Este sistema de regulación interna de los organismos vivos se denomina homeostato.

La característica básicas de cualquier controlador como dispositivo de procesamiento de información es la sustitución de la conversión de la información que es implementada por el controlador. Estas leyes en diferentes controladores pueden variar considerablemente, desde la transformación lineal en los sistemas mecánicos más simples hasta las leyes más complejas del pensamiento humano.

Una de las principales tareas de la cibernética es estudiar los principios de construcción y funcionamiento de diversos controladores y crear una teoría general de control, es decir, una teoría general de la transformación de información en los controladores. La base matemática para crear tal teoría de la transformación de información es la lógica matemática, una ciencia que estudia las relaciones entre premisas y consecuencias por métodos matemáticos. En esencia, la lógica matemática proporciona una justificación teórica para los métodos de transformación de la información, lo que justifica la estrecha conexión entre la lógica matemática y la cibernética.

Sobre la base de la lógica matemática, han aparecido numerosas aplicaciones especiales de esta ciencia a diversos sistemas de tratamiento de la información, que se están desarrollando rápidamente: teoría de circuitos de relé-contacto, teoría de la síntesis de circuitos electrónicos de computación y control, teoría de programación de máquinas electrónicas de cálculo automático, etc.

La tarea principal que hay que resolver durante el desarrollo de un esquema de tal o cual dispositivo de procesamiento de la información es la siguiente: se especifica un cierto conjunto de información de entrada posible y una función que determina la dependencia de la información de salida de la información de entrada, es decir, la cantidad de información que hay que procesar y la ley de su procesamiento. Es necesario construir un esquema óptimo que realice esta dependencia, es decir, el procesamiento de una determinada cantidad de información.

Es posible imaginar una solución a este problema en la que se construye un circuito separado para implementar cada dependencia, es decir, para transmitir cada posible variante de información. Esta es la forma más sencilla y menos ventajosa de resolverlo. La tarea de la teoría consiste en asegurar la transmisión de una cantidad determinada de información mediante la combinación de tales circuitos separados con la ayuda de una cantidad mínima de elementos físicos necesarios para la construcción de circuitos. Al mismo tiempo, es necesario lograr la fiabilidad e inmunidad al ruido de los sistemas.

Sin embargo, en las soluciones prácticas de ingeniería a estos problemas no es posible obtener soluciones absolutamente óptimas. Es necesario considerar la viabilidad de construir máquinas a partir de un cierto número de conjuntos y piezas estándar, sin aumentar significativamente el número de variantes del diseño en la búsqueda de la optimización.

Se trata de un término medio entre los requisitos de una solución óptima y la viabilidad de la implementación de los esquemas, la tarea de evaluar la calidad de los esquemas y las unidades derivadas de las piezas estándar disponibles, en términos de hasta qué punto estos esquemas se acercan a la solución óptima o cómo utilizar las piezas estándar y unidades disponibles para acercarse lo máximo posible a la solución óptima.

Lo mismo también ocurre con la programación para resolver problemas matemáticos en máquinas computadoras de acción rápida. La composición de un programa consiste en determinar la secuencia de operaciones realizadas por la máquina que dará lugar a la solución del problema. Esto se explicará con más detalle a continuación.

El requisito de una programación óptima en términos de tiempo mínimo de funcionamiento de la máquina prácticamente no se cumple, porque conlleva demasiado trabajo componer cada programa. Por tanto, se pueden formar variantes del programa que no se alejen demasiado de las variantes óptimas mediante técnicas más o menos estándar y conocidas.

Los problemas aquí considerados son casos especiales del problema general que resuelve la teoría de la información estadística: el problema de la forma óptima de transmitir y transformar la información.

La teoría de la información establece la posibilidad de representar cualquier información, independientemente de su naturaleza física específica (incluida la información dada por las funciones continuas), de forma unificada como un conjunto de elementos binarios individuales, los llamados cuantos de información, es decir, elementos, cada uno de los cuales puede tener sólo uno de dos valores posibles: «sí» o «no».

La teoría de la información se ocupa de dos cuestiones principales: a) la medición de la cantidad de información y b) la calidad o fiabilidad de la información. El primero tiene que ver con el ancho de banda y la capacidad de los distintos sistemas de procesamiento de información; el segundo, con la fiabilidad e inmunidad de estos sistemas.

La cantidad de información proporcionada por una fuente o transmitida en un tiempo determinado a través de un canal se mide por el logaritmo del número total (n) de diferentes versiones igualmente probables de la información que podrían haber sido proporcionadas por esa fuente o transmitida en un tiempo determinado.

La medida logarítmica se adopta a partir de las condiciones para mantener la proporcionalidad entre la cantidad de información que puede transmitirse en un periodo de tiempo y el tamaño de ese periodo y entre la cantidad de información que puede almacenarse en un sistema y el número de elementos físicos (como los relés) necesarios para construir ese sistema. La elección de la base del logaritmo viene determinada por la elección de la unidad de medida de la cantidad de información. Con una base de dos, la unidad de cantidad de información es el mensaje más simple y elemental sobre el resultado de elegir una dos posibilidades igualmente probables «sí» o «no». Para denotar esta unidad de cantidad de información, se introdujo un nombre especial «bit» (de las letras iniciales del término binary digit, que significa dígito binario).

El caso más sencillo para determinar la cantidad de información es cuando las distintas variantes posibles de un mensaje tienen la misma probabilidad.

Debido a la naturaleza masiva de la información, se introduce su estructura estadística. Las variantes individuales de los datos posibles, como los mensajes individuales en la teoría de la comunicación, no se consideran como funciones dadas del tiempo, sino como un conjunto de diferentes variantes posibles definidas junto con sus probabilidades de ocurrencia.

En general, las variantes individuales de los datos tienen diferentes probabilidades, y la cantidad de información en un mensaje depende de la distribución de estas probabilidades.

La definición matemática de la cantidad de información es la siguiente. En teoría de la probabilidad, un sistema completo de sucesos es un grupo de sucesos A1 A2… An , en el que uno y sólo uno de estos sucesos ocurre necesariamente en cada ensayo. Por ejemplo, una tirada de 1, 2, 3, 4, 5 o 6 en un dado; una cara o una cruz en un lanzamiento de una moneda. Para este último caso existe una alternativa simple: un par de eventos opuestos.

Un esquema finito es un sistema completo de eventos A1, A2… An , dados junto con sus probabilidades: P1 P2 … Pn,

| Evento | A1 | A2 | … | An |

| Probabilidad | P1 | P2 | … | Pn |

donde:

Cualquier esquema finito es hasta cierto grado incierto, es decir, sólo se conocen las probabilidades de los posibles eventos, pero no se sabe qué evento ocurrirá.

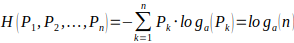

La teoría de la información introduce la siguiente característica para estimar el grado de incertidumbre de cualquier patrón finito de eventos:

donde los logaritmos se pueden tomar en una base arbitraria, pero siempre la misma, y donde Pk=0 se toma como Pk*logPk=0. El valor H se denomina entropía de un determinado esquema finito de acontecimientos (véase C. Shannon, «Mathematical Theory of Communication». Colección de traducciones «Transmisión de señales eléctricas en presencia de perturbaciones». M 1953, y A. Y. Khinchin, «The Notion of Entropy in Probability Theory». Revista “Avances en Ciencias Matemáticas”. Т. 3. 1953). Tiene las siguientes propiedades:

1. El valor H(P1, P2, …, Pn) es continuo con respecto a Pk.

2. El valor H(P1, P2, …, Pn) = 0 si y sólo si alguno de los números P1 P2 … Pn es igual a uno y los demás son cero, es decir, la entropía es cero cuando no hay incertidumbre en el esquema final.

3. El valor H(P1, P2, …, Pn) tiene un valor máximo cuando todos los P k son iguales entre sí, es decir, cuando el esquema final tiene la mayor incertidumbre. En este caso, como es fácil de ver,

Además, la entropía tiene la propiedad aditiva, es decir, la entropía de dos circuitos finitos independientes es igual a la suma de las entropías de estos circuitos finitos.

Así, se puede ver que la expresión de entropía elegida es bastante conveniente y caracteriza completamente el grado de incertidumbre de un patrón finito de eventos dado.

La teoría de la información demuestra que la única forma que satisface las tres propiedades anteriores es la forma aceptada para expresar la entropía

Los datos obtenidos de una prueba donde los resultados posibles fueron determinados mediante cierto esquema final A representan una información que elimina la incertidumbre que existía antes de la prueba. Naturalmente, cuanto mayor sea la incertidumbre en el diseño final, más información obtendremos de la prueba y de la eliminación de esa incertidumbre. Dado que una característica del grado de incertidumbre de cualquier esquema finito es su entropía, es razonable medir la cantidad de información proporcionada por la prueba mediante esa misma cantidad.

Así, en el caso general, la cantidad de información de cualquier sistema que tenga diferentes probabilidades para posibles resultados viene determinada por la entropía del esquema de coeficientes que caracteriza el comportamiento de ese sistema.

Como la unidad de información se toma el tipo de información más simple y uniforme, esta es, el mensaje sobre el resultado de una elección entre dos opciones igualmente probables, la base de los logaritmos en la expresión de la entropía se toma como dos.

Como puede verse en (4), en el caso de un esquema finito con eventos de igual probabilidad, la fórmula (1) se obtiene como un caso especial de (2)

La teoría de la información ofrece un método muy general para evaluar la calidad de la información, su fiabilidad. Cualquier información se considera el resultado de dos procesos: un proceso regular diseñado para transmitir la información requerida y un proceso aleatorio causado por la acción de las interferencias. Este enfoque de la evaluación de la calidad de los distintos sistemas es común a varias ciencias: la radioingeniería, la teoría del control automático, la teoría de la comunicación, la teoría matemática de las máquinas, etc.

La teoría de la información propone que la calidad de la información no se mida por la relación entre los niveles de la señal útil y las interferencias, sino por el método estadístico: la probabilidad de obtener la información correcta.

La teoría de la información estudia la relación entre la cantidad y la calidad de la información; investiga los métodos de transformación de la información para maximizar la eficacia de los distintos sistemas de tratamiento de la información y averiguar los principios óptimos para la construcción de dichos sistemas.

De gran importancia en la teoría de la información, por ejemplo, es la noción de que la cantidad de información puede aumentarse reduciendo la calidad, e inversamente, la calidad de la información puede mejorarse reduciendo la cantidad de información transmitida.

Además de las amplias generalizaciones científicas y el desarrollo de un nuevo enfoque unificado para el estudio de diversos procesos de interacción con el cuerpo, la teoría de la información también señala importantes vías prácticas para el desarrollo de la tecnología de la comunicación. Por ejemplo, los métodos desarrollados sobre la base de la teoría de la información para la recepción de señales débiles en presencia de interferencias que superan significativamente la potencia de las señales recibidas son extremadamente importantes en la actualidad. Una forma prometedora, indicada por la teoría de la información, es mejorar la eficacia y la fiabilidad de las líneas de comunicación pasando de la recepción de señales individuales y únicas a la recepción y el análisis de agregados de estas señales e incluso a la recepción de mensajes enteros a la vez. Sin embargo, esta vía sigue encontrando serias dificultades prácticas, principalmente relacionadas con la necesidad de disponer de dispositivos de almacenamiento suficientemente grandes y rápidos en los equipos de comunicación.

En el estudio de la información, la cibernética combina elementos comunes de diversos campos de la ciencia: la teoría de la comunicación, la teoría de los filtros y la anticipación, la teoría de los sistemas de seguimiento, la teoría del control automático con retroalimentación, la teoría de las máquinas computadoras electrónicas, la fisiología, etc., tratando los diversos objetos de estas ciencias desde una perspectiva unificada como sistemas de procesamiento y transmisión de información.

No cabe duda de que la creación de una teoría general de los sistemas y procesos controlados automáticamente, la elucidación de las leyes generales del control y la comunicación en diversos sistemas organizados, incluso en los organismos vivos, será de suma importancia para el futuro desarrollo exitoso del complejo de las ciencias. La principal importancia y valor de la nueva tendencia científica —la cibernética— radica en plantear la cuestión de la creación de una teoría general del control y la comunicación, que generalice los logros y métodos de diversos campos distintos de la ciencia.

Las razones objetivas que condujeron a la aparición de la cibernética como rama de la ciencia fueron los grandes logros en el desarrollo de todo un complejo de disciplinas teóricas, como la teoría del control automático y las oscilaciones, la teoría de las máquinas computadoras electrónicas, la teoría de la comunicación, etc., y el alto nivel de desarrollo de las herramientas y los métodos de automatización, que proporcionaron amplias oportunidades prácticas para crear diversos dispositivos automáticos.

Es necesario destacar la gran importancia metodológica de la cuestión planteada por la cibernética sobre la necesidad de generalizar, de combinar de forma amplia los resultados y los logros de diferentes campos de la ciencia, que se desarrollan en cierto modo de forma aislada, como la fisiología y la automática, la teoría de la comunicación y la mecánica estadística.

Este aislamiento, la separación de los distintos campos de la ciencia, debido principalmente a las diferencias en los objetos físicos específicos de estudio, se refleja en métodos de investigación y terminología diferentes, creando hasta cierto punto divisiones artificiales entre los distintos campos de la ciencia.

En ciertas etapas del desarrollo de la ciencia, es inevitable la interpenetración de las distintas ciencias, el intercambio de logros, experiencias y su generalización, lo que debería contribuir al ascenso de la ciencia a un nuevo nivel superior.

Se han expresado opiniones sobre la necesidad de limitar el alcance de la nueva teoría principalmente al campo de la teoría de la comunicación, por considerar que las amplias generalizaciones podrían llevar a una confusión perjudicial en la actualidad. Este enfoque no puede considerarse correcto. Ya se han identificado una serie de conceptos (en los que la cibernética ha desempeñado un papel importante) de importancia teórica general. Entre ellos se encuentra, en primer lugar, el principio de retroalimentación, que desempeña un papel fundamental en la teoría del control automático y la oscilación y es de gran importancia para la fisiología.

La idea de considerar la naturaleza estadística de la interacción entre los sistemas de información tiene una importancia teórica general. Por ejemplo, el concepto de entropía en la teoría de la probabilidad tiene un significado teórico general, y sus aplicaciones particulares se aplican al campo de la termodinámica estadística, así como al campo de la teoría de la comunicación, y posiblemente también a otros campos. Estas leyes generales tienen un carácter objetivo y la ciencia no puede ignorarlas.

El nuevo campo científico está todavía en su fase de formación, incluso el alcance de la nueva teoría no se ha definido aún con claridad; los nuevos datos llegan en un flujo continuo. El valor de la nueva teoría reside en la amplia generalización de los logros de las distintas ciencias particulares y en el desarrollo de principios y métodos generales. El reto es asegurar el desarrollo exitoso de la nueva disciplina científica en nuestro país.

2. Las máquinas computadoras electrónicas y el sistema nervioso

Además de investigar y modelar físicamente los procesos que tienen lugar en los seres vivos, la cibernética se ocupa de desarrollar autómatas más sofisticados y complejos capaces de realizar algunas de las funciones inherentes al pensamiento humano en sus formas más simples.

Cabe señalar que los métodos de modelización, los métodos de analogía se han aplicado constantemente en las investigaciones científicas tanto en las ciencias biológicas como en las ciencias exactas y la ingeniería. En la actualidad, gracias al desarrollo de la ciencia y la tecnología, ha aparecido la posibilidad de aplicar este método por analogía para estudiar las leyes de la actividad del sistema nervioso, el cerebro y otros órganos humanos de forma más profunda y completa por medio de complicadas máquinas y dispositivos electrónicos y, por otra parte, para utilizar los principios y las leyes de las funciones vitales de los organismos vivos para la creación de dispositivos automáticos más perfectos.

El hecho de que la cibernética se enfrente a tales retos es sin duda un aspecto positivo de este campo, de gran importancia científica y aplicada. La cibernética señala la analogía general entre el principio de funcionamiento del sistema nervioso y el de una máquina computadora automática, que es la presencia de procesos de conteo y pensamiento lógico autoorganizados.

Los principios básicos de las máquinas computadoras electrónicas son los siguientes.

Una máquina puede realizar varias operaciones elementales específicas: sumar dos números, restar, multiplicar, dividir, comparar números por su valor, comparar números por sus signos y algunas otras. Cada una de estas operaciones es realizada por la máquina como efecto de un comando específico que determina qué operación y en qué números debe realizar la máquina y dónde debe guardarse el resultado de la operación.

Una secuencia de estos comandos constituye el programa de trabajo de la máquina. El programa debe ser escrito previamente por un matemático humano e introducido en la máquina antes de resolver el problema, tras lo cual la solución completa del problema es llevada a cabo por la máquina de forma automática, sin intervención humana. Para introducirla en la máquina, cada instrucción del programa se codifica como un número simbólico, que la máquina descodifica en consecuencia durante la resolución del problema, y se ejecuta la instrucción necesaria.

Una máquina computadora automática tiene la capacidad de almacenar —para recordar— una gran cantidad de números (cientos de miles de números), emitir los números necesarios para la operación de forma automática durante el proceso de solución y volver a guardar los resultados de la operación. Los números simbólicos, que representan el programa, se almacenan en la máquina en los mismos dispositivos de memoria que los números normales.

Las dos características siguientes son muy importantes desde el punto de vista del principio de las máquinas computadoras electrónicas:

1. La máquina tiene la capacidad de cambiar automáticamente el curso del proceso de cálculo en función de los resultados de cálculo obtenidos. Normalmente, los comandos del programa son ejecutados por la máquina en el orden en que están escritos en el programa. Sin embargo, incluso con los cálculos manuales, a menudo es necesario cambiar el curso de los cálculos (por ejemplo, el tipo de fórmula, el valor de una determinada constante, etc.), en función de los resultados obtenidos durante los cálculos. Esto se garantiza en una máquina mediante la introducción de operaciones de transición especiales que permiten elegir diferentes formas de cálculos posteriores en función de los resultados anteriores.

2. Dado que el programa de la máquina, representado en forma de una secuencia de números simbólicos, se almacena en la misma unidad de memoria de la máquina, como los números convencionales, la máquina puede realizar operaciones no sólo con los números convencionales, que representan los valores implicados en la resolución del problema, sino también con los números simbólicos que representan las órdenes del programa. Esta propiedad de la máquina garantiza la posibilidad de transformación y repetición múltiple de todo el programa o sus partes separadas en el proceso de cálculos que proporciona una reducción considerable de la entrada del programa inicial en la máquina y reduce drásticamente la entrada de mano de obra en el proceso de compilación del programa.

Estas dos características principales de las máquinas computadoras electrónicas son la base para realizar un proceso de cálculo totalmente automático. Permiten que una máquina evalúe con determinados criterios el resultado obtenido en el proceso de cálculo, y elabore por sí misma un programa de trabajo posterior, basándose únicamente en algunos principios generales iniciales establecidos en el programa introducido inicialmente en la máquina.

Estas características representan la principal y más notable propiedad de las modernas máquinas computadoras electrónicas, que proporciona amplias posibilidades de uso de las máquinas también para resolver problemas lógicos, modelar circuitos y procesos lógicos, modelar diversos procesos probabilísticos y otras aplicaciones. Estas posibilidades aún están lejos de ser dilucidadas por completo.

Así, el principio básico en el funcionamiento de una máquina computadora es que siempre hay algún proceso de autoorganización que está determinado, por un lado, por la naturaleza de los datos de entrada y los principios subyacentes del programa introducido inicialmente y, por otro, por las propiedades lógicas del propio diseño de la máquina.

La teoría de estos procesos de autoorganización, en particular los que están sujetos a las leyes de la lógica formal, es principalmente la parte de la teoría de las máquinas computadora electrónicas de la que se ocupa la cibernética.

En esta relación, la cibernética establece una analogía entre el funcionamiento de una máquina computadora y el funcionamiento del cerebro humano para resolver problemas lógicos.

La cibernética constata no sólo la analogía entre el principio de funcionamiento del sistema nervioso y el de la máquina computadora en presencia de procesos de conteo y de pensamiento lógico autoorganizados, sino también la analogía en el mecanismo de funcionamiento de la máquina y del propio sistema nervioso.

Todo el proceso de una máquina computadora para resolver cualquier problema matemático o lógico consiste en un enorme número de elecciones binarias consecutivas, en las que las posibilidades de las elecciones posteriores están determinadas por los resultados de las elecciones anteriores. Así pues, el funcionamiento de una máquina computadora consiste en implementar una larga y continua cadena lógica, cada eslabón de la cual sólo puede tener dos valores: «sí» o «no».

Las condiciones específicas que se dan cada vez que se ejecuta un enlace individual garantizan que uno de los dos estados sea siempre una elección bien definida e inequívoca. Esta elección viene determinada por los datos iniciales de la tarea, el programa de solución y los principios lógicos incorporados en el diseño de la máquina.

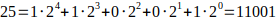

Esto es especialmente evidente en el caso de las máquinas trabajando con números binarios. En el sistema numérico binario, a diferencia del sistema numérico decimal convencional, la base del sistema no es el número 10 sino el número 2. El binario sólo tiene dos dígitos, 0 y 1, y cualquier número se representa como una suma de potencias de dos. Por ejemplo,

Todas las acciones de la aritmética binaria se reducen a una serie de elecciones binarias. No es difícil ver que cualquier operación sobre números escritos en binario es una operación para encontrar dígitos individuales del resultado, es decir, para encontrar cantidades que toman sólo dos valores, 1 o 0, dependiendo de los valores de todos los dígitos de cada una de las entradas.

En consecuencia, la obtención de un resultado se reduce a calcular varias funciones que toman dos valores basadas en argumentos que toman dos valores. Se puede demostrar que cualquier función de este tipo se representa como algún polinomio de sus argumentos, es decir, una expresión que consiste en combinaciones de estos argumentos conectados por adición y multiplicación. La multiplicación de tales números es obvia; en cuanto a la suma, debe entenderse de forma convencional, tomando 1+1=0, es decir, considerando que dos es equivalente a cero.

En lugar de la adición aritmética, podemos introducir otra, la adición «lógica», en la que 1+1=1, y de nuevo mediante una simple combinación de dos operaciones obtenemos cualquier función llamada lógica de muchas variables.

Esto facilita la construcción de cualquier circuito de máquina lógica combinando dos circuitos sencillos, uno que realiza la suma y el otro la multiplicación por separado.

Por lo tanto, una máquina lógica se compone de elementos que adoptan dos posiciones.

En otras palabras, el dispositivo de la máquina es un conjunto de relés con dos estados: «encendido» y «apagado». En cada etapa del cálculo, cada relé toma una determinada posición dictada por las posiciones del grupo o de todos los relés en la etapa anterior de la operación.

Estas etapas de funcionamiento pueden «sincronizarse» definitivamente desde un sincronizador central, o bien retrasar la acción de cada relé hasta que todos los relés que deberían haber actuado antes en el proceso hayan pasado todos los ciclos necesarios. Físicamente, los relés pueden ser diferentes: mecánicos, electromecánicos, eléctricos, electrónicos, etc.

Se sabe que el sistema nervioso de un animal contiene elementos que se asemejan en su funcionamiento al de los relés. Son lo que se conoce como neuronas, o células nerviosas. Aunque la estructura de las neuronas y sus propiedades son bastante complejas, en su estado fisiológico normal funcionan según el principio de «sí» o «no». Las neuronas están o bien en reposo o bien excitadas, y durante la excitación pasan por una serie de etapas casi independientes de la naturaleza e intensidad del estímulo. Primero viene la fase activa, que se transmite de un extremo a otro de la neurona a un ritmo determinado, seguida del periodo refractario, durante el cual la neurona no se excita. Al final del periodo refractario la neurona permanece inactiva, pero ya puede ser excitada de nuevo, es decir, la neurona puede considerarse como un relé con dos estados de actividad.

A excepción de las neuronas que reciben la excitación de los extremos libres, o terminaciones nerviosas, cada neurona recibe la excitación de otras neuronas en puntos de conexión llamados sinapsis. El número de estos puntos de conexión varía de unos pocos a muchos cientos para diferentes neuronas.

La transición de una neurona determinada al estado de excitación dependerá de la combinación de los impulsos de excitación entrantes de todas sus sinapsis y del estado en que se encontraba la neurona anteriormente. Si una neurona no está en estado de excitable y está en un estado no refractario, y el número de sinapsis de las neuronas vecinas que están en estado de excitación durante un determinado y muy corto periodo de coincidencia supera un determinado límite, entonces esta neurona se excitará después de un determinado retraso sináptico. Aún así, este esquema de la excitación de las neuronas es muy simplista.

El «límite» puede depender no sólo del número de sinapsis, sino también de su «expectativa» y de su disposición geométrica. Además, hay pruebas de que existen sinapsis de otra naturaleza, las llamadas «sinapsis inhibitorias», que impiden absolutamente la excitación de una determinada neurona o elevan el límite de su excitación mediante sinapsis convencionales.

Sin embargo, está claro que ciertas combinaciones específicas de impulsos procedentes de neuronas vecinas que se encuentran en estado de excitación y tienen conexiones sinápticas con una neurona determinada llevarán a esa neurona a un estado de excitación, mientras que otras neuronas no afectarán a su estado.

Una función muy importante del sistema nervioso y de las máquinas de computación es la memoria.

Hay varios tipos de memoria disponibles en las máquinas de computación. La memoria volátil garantiza el almacenamiento y la salida rápida de los datos necesarios para una operación. Después de realizar una operación determinada, esta memoria puede borrarse y prepararse así para la siguiente operación. La memoria volátil en las máquinas se implementa mediante células electrónicas de disparo, tubos de haz de electrones o líneas de retardo electroacústicas y otros dispositivos electrónicos o magnéticos.

También hay una memoria permanente para el almacenamiento a largo plazo en la máquina para todos los datos que se necesitarán en futuras operaciones. La memoria permanente se implementa en las máquinas mediante grabaciones en cinta magnética, tambor o cable, mediante cinta perforada, tarjetas perforadas, fotografías y otros métodos.

Hay que tener en cuenta que el cerebro, bajo las condiciones normales de funcionamiento de la memoria, no es ciertamente una analogía completa de una máquina de computación. Una máquina, por ejemplo, puede resolver cada nueva tarea con una memoria completamente despejada, mientras que el cerebro siempre conserva más o menos información anterior.

Así, el trabajo del sistema nervioso, el proceso del pensamiento, incluye un enorme número de actos elementales de neuronas separadas. Cada acto elemental de la reacción de la neurona al estímulo, la descarga de la neurona, es similar al acto elemental de una máquina computadora, que tiene la oportunidad de elegir sólo una de dos variantes en cada caso particular.

La diferencia cualitativa entre el proceso de pensamiento humano y el animal viene dada por la presencia del llamado segundo sistema de señales, es decir, el sistema condicionado por el desarrollo del habla, el lenguaje humano. Los seres humanos utilizan ampliamente las palabras en el proceso de pensamiento, perciben las palabras como estímulos; los procesos de análisis y síntesis y los procesos de pensamiento abstracto se llevan a cabo con la ayuda de las palabras.

Las máquinas computadoras electrónicas tienen una cierta semejanza primitiva a un lenguaje —este es su sistema de comandos, números condicionales, el sistema de direcciones de memoria y el sistema de varias señales que implementan varias transiciones condicionales e incondicionales en el programa, implementando el control del trabajo de la máquina. La presencia de ese «lenguaje» de la máquina es lo que permite realizar en ella algunos procesos lógicos propios del pensamiento humano.

En general, la cibernética considera que las máquinas computadoras electrónicas son sistemas de procesamiento de información.

Para investigar la eficacia y analizar los principios de funcionamiento convenientes, las formas de diseño de las máquinas computadoras electrónicas, la cibernética propone tener en cuenta la naturaleza estadística de la información que llega a la máquina y se procesa —problemas matemáticos, métodos de solución, datos iniciales, resultados de las soluciones.

Este enfoque encuentra su analogía en los principios del sistema nervioso y el cerebro de los animales y los seres humanos, que interactúan con el entorno externo desarrollando reflejos condicionados y un proceso de aprendizaje, en última instancia mediante una contabilidad estadística de las influencias externas.

Los principios de las máquinas computadoras electrónicas permiten aplicar procesos lógicos en estas máquinas, de forma similar al proceso de desarrollo de los reflejos condicionados en los animales y los seres humanos.

La máquina puede programarse para que responda de una manera determinada cuando se le envía una determinada señal, y dependiendo de la frecuencia con la que se envíe la señal, la máquina responderá de manera más o menos fiable. Si la señal no se da durante mucho tiempo, la máquina puede olvidar la respuesta.

Así, una máquina de computación en funcionamiento es algo más que un grupo de relés y almacenamientos interconectados. La máquina en funcionamiento también incluye el contenido de sus unidades de almacenamiento, que nunca se borran por completo en el proceso de cálculo.

A este respecto es interesante la siguiente afirmación de N. Wiener: «El cerebro mecánico no segrega el pensamiento como el hígado la bilis, como se ha escrito antes, ni lo excreta en forma de energía, como los músculos excretan su energía.

La información es información, no materia ni energía. Ningún materialismo, que no lo permita, puede existir en la actualidad». Wiener subraya en esta afirmación que la capacidad de «pensar» de una máquina de computación no es una propiedad orgánica de la propia máquina como construcción, sino que está determinada por la información, en particular el programa, que el humano introduce en la máquina.

Es necesario tener un claro entendimiento de la diferencia fundamental y cualitativa entre el proceso de pensamiento humano y el funcionamiento de una máquina computadora.

Debido al enorme número de células nerviosas, el cerebro humano contiene un gran número de conexiones elementales diversas, combinaciones condicionalmente reflexivas e incondicionalmente reflexivas, que generan formas únicas y muy extrañas de creatividad y pensamiento abstracto, inagotables en su riqueza de variantes, contenido y profundidad. I. P. Pavlov escribió que el cerebro humano contiene un número tan grande de conexiones elementales que un hombre apenas utiliza la mitad de estas posibilidades en el curso de su vida.

Sin embargo, una máquina puede tener ventajas sobre los humanos en la estrecha especialización de su trabajo. Estas ventajas residen en la infatigabilidad, la infalibilidad, la adhesión impecable a los principios operativos establecidos, los axiomas subyacentes del razonamiento lógico en la resolución de tareas humanas específicas. Las máquinas computadoras electrónicas pueden simular, realizar sólo procesos separados y estrechamente dirigidos del pensamiento humano.

Así pues, las máquinas no sustituyen ni sustituirán nunca al cerebro humano, al igual que una pala o una excavadora no sustituyen a las manos humanas, y los coches o los aviones no sustituyen a las piernas.

Las máquinas computadoras electrónicas son herramientas para el pensamiento humano, al igual que otras herramientas son herramientas para el trabajo físico humano. Estas herramientas amplían la capacidad del cerebro humano, liberándolo de las formas más primitivas y monótonas de pensamiento, como, por ejemplo, en la realización de trabajos de cálculo, en el razonamiento y la comprobación de la lógica formal, finalmente, en la realización de diversos trabajos económicos y estadísticos (por ejemplo, la programación de trenes, la planificación del transporte, el abastecimiento, la producción, etc.). Y como instrumentos de trabajo —pensamiento— las máquinas computadoras electrónicas tienen ilimitadas perspectivas de desarrollo. Los procesos de pensamiento humano, cada vez más complejos y nuevos, se realizarán mediante máquinas computadoras electrónicas. Pero la sustitución del cerebro por máquinas, su equivalencia es impensable.

Las estructuras del cerebro y de la máquina computadora son cualitativamente diferentes. El cerebro tiene una estructura localmente aleatoria a pesar de la estricta organización general y la especialización del trabajo de sus partes individuales. Esto significa que el número de neuronas, así como su disposición y conexiones mutuas, pueden variar en cada sección individual hasta cierto punto de forma aleatoria, mientras que la distribución de funciones y conexiones entre las secciones individuales del cerebro es estricta. Las máquinas computadoras electrónicas no pueden tener hoy en día ninguna aleatoriedad en sus esquemas de conexión, la composición de los elementos y su funcionamiento.

En relación con esta diferencia en la organización del cerebro y la máquina, existe también una diferencia significativa en la fiabilidad de su funcionamiento.

El cerebro es un órgano excepcionalmente robusto. El fallo de las células nerviosas individuales no afecta en absoluto al rendimiento del cerebro. Sin embargo, en una máquina, el fallo de un solo componente entre cientos de miles, o la interrupción de un solo contacto entre cientos de miles de contactos, puede hacer que la máquina sea completamente inoperable.

Además, el propio cerebro humano está en continua evolución a través del proceso de creatividad, y es esta capacidad de autodesarrollo infinito la principal característica distintiva del cerebro humano, que nunca podrá realizarse plenamente en una máquina.

Del mismo modo, la capacidad de creatividad del cerebro humano: la clasificación y recuperación amplia y flexible de imágenes en la memoria, el establecimiento de una retroalimentación estable y el análisis y la síntesis de conceptos, es prácticamente imposible de alcanzar en su totalidad por una máquina.

El cerebro humano es el creador de todas las máquinas más complejas y perfectas que, con toda su complejidad y perfección, no son más que herramientas del trabajo humano, tanto físico como mental.

Así pues, las máquinas computadoras electrónicas sólo pueden representar un esquema extremadamente burdo y simplificado de los procesos de pensamiento. Este esquema sólo es análogo a los procesos de pensamiento humano individuales y estrechamente enfocados en sus formas más simples, que no contienen elementos de creatividad.

Pero aunque hay una gran diferencia entre el cerebro y una máquina computadora, la creación y aplicación de máquinas computadoras electrónicas para simular los procesos de la actividad nerviosa superior debería ser de la mayor importancia para la fisiología. Hasta ahora, la fisiología sólo ha podido observar el funcionamiento del cerebro. Ahora existe la oportunidad de experimentar, de crear modelos, incluso de los procesos de pensamiento más burdos y primitivos, y al examinar el trabajo de estos modelos, aprender más profundamente las leyes de la actividad nerviosa superior. Esto significa un desarrollo adicional del método objetivo de estudio de la actividad nerviosa superior, propuesto por I.P. Pavlov.

Al investigar el principio de funcionamiento del sistema nervioso y de las máquinas computadoras electrónicas, los principios de retroalimentación en las máquinas y en los organismos vivos, las funciones de la memoria en las máquinas y en los seres vivos, la cibernética plantea la cuestión de lo común y lo diferente en el organismo vivo y en la máquina de una manera nueva y generalizada.

Esta formulación del problema, si se observa con rigor y profundidad, puede arrojar resultados de gran alcance en los campos de la psicopatología, la neuropatología y la fisiología del sistema nervioso.

Cabe señalar que ya se han publicado en la prensa informes sobre el desarrollo de algunos modelos fisiológicos electrónicos. Por ejemplo, se han desarrollado modelos para estudiar el corazón y sus enfermedades. Se ha desarrollado un dispositivo de computación electrónico que hace posible que una persona ciega lea un texto impreso normal. Este aparato lee las letras y las transmite en forma de señales sonoras de diferentes tonos. Tras el desarrollo de este dispositivo se comprobó que su circuito se asemeja en cierta medida al conjunto de conexiones de la corteza cerebral humana, encargada de la percepción visual. Así, los métodos de simulación electrónica están empezando a aplicarse de forma práctica en la fisiología. La tarea es, dejando a un lado la charla sobre la «pseudociencia» de la cibernética, que a menudo encubre la simple ignorancia en la ciencia, investigar los límites de la admisibilidad de tal modelización, revelar aquellas limitaciones en el funcionamiento de los sistemas de computación electrónicos, que son las más esenciales para la representación correcta de los procesos de pensamiento investigados, y establecer tareas para los diseñadores de máquinas para crear nuevos modelos más perfectivos.

3. La aplicación de la cibernética

Actualmente se presta mucha atención en el extranjero a la investigación teórica y experimental en el campo de la cibernética. Prácticamente se están desarrollando y construyendo autómatas complejos que realizan diversas funciones lógicas, en particular autómatas que pueden dar cuenta de entornos externos complejos y memorizar sus acciones.

El desarrollo de estas máquinas automáticas fue posible gracias a la utilización de máquinas de computación electrónica controladas por un programa en los sistemas de automatización. El uso de máquinas de computación electrónica para el control y la regulación automática marca una nueva etapa en el desarrollo de la automatización. Hasta ahora los autómatas, a menudo muy complejos, se construían para funcionar en condiciones específicas y predeterminadas. Estas máquinas automáticas tenían parámetros constantes y funcionaban según reglas y leyes constantes de regulación o control.

La introducción de máquinas de computación electrónica en los sistemas de control permite llevar a cabo la llamada regulación óptima, o regulación con estimación previa de posibilidades. En este caso, la máquina computadora, en función de los datos que le llegan, caracterizando el estado actual del sistema y el entorno externo, calcula posibles variantes del comportamiento futuro del sistema con diversos métodos de regulación, teniendo en cuenta los cambios futuros de las condiciones externas, obtenidos por extrapolación.

Analizando las soluciones obtenidas en función de algún criterio de control óptimo (por ejemplo, el tiempo de control mínimo), la máquina computadora selecciona la variante óptima teniendo en cuenta el comportamiento anterior del sistema. Si es necesario, un sistema de control de este tipo también puede modificar los parámetros del propio sistema de control, garantizando el curso óptimo del proceso de control. El desarrollo de estas máquinas automáticas es de gran importancia económica y militar.

Es especialmente importante el problema de crear máquinas automáticas que realicen diversas funciones del pensamiento humano. La condición necesaria para la aplicación de las máquinas de computación electrónicas para la mecanización de este o aquel campo del trabajo mental para la gestión de cualquier proceso es el enunciado matemático del problema, la presencia de la descripción matemática del proceso o cierto algoritmo lógico del trabajo dado. Sin duda, estas aplicaciones no informáticas de las máquinas de computación automáticas tienen una importancia primordial y unas perspectivas de desarrollo inusualmente amplias como medio para ampliar las posibilidades cognitivas del cerebro humano, para dotar al hombre de instrumentos de trabajo aún más perfectos, tanto físicos como mentales.

Algunos ejemplos de tecnología cibernética son: la traducción automática de un idioma a otro por medio de una máquina computadora electrónica; la compilación de programas para la computación en máquinas por medio de las propias máquinas; la utilización de máquinas computadoras electrónicas para diseñar complejos circuitos de conmutación y control, para controlar fábricas automatizadas, para planificar y controlar el tráfico ferroviario y aéreo, etc.; la creación de máquinas automáticas especiales para regular el tráfico en las calles, para leer a los ciegos, etc.

Cabe señalar que el desarrollo de la aplicación de las máquinas computadoras electrónicas en la automática es de gran importancia económica y militar. Construyendo tales máquinas automáticas e investigando su funcionamiento, es posible estudiar las leyes de construcción de toda una clase de dispositivos automáticos que pueden aplicarse en la industria y en los asuntos militares. Por ejemplo, la bibliografía (véase Tele-Tech 153, 12, nº 8) ofrece un esquema de una instalación totalmente automática que, gracias a un sistema de propulsión nuclear, puede funcionar de forma autónoma durante mucho tiempo, y también un esquema de un dispositivo para el control automático de los disparos desde un avión hacia un blanco volante.

* * *

Hay que señalar que hasta hace poco ha habido una mala interpretación de la cibernética en nuestra literatura popular, el silenciamiento de los trabajos sobre cibernética, ignorando incluso los logros prácticos en este campo. La cibernética ha sido calificada nada menos que de pseudociencia idealista.

Sin embargo, no cabe duda de que la idea de estudiar y modelar los procesos que ocurren en el sistema nervioso humano mediante sistemas electrónicos automáticos es en sí misma profundamente materialista, y los avances en este campo sólo pueden contribuir a establecer una visión materialista del mundo basada en los últimos avances de la tecnología moderna.

Algunos de nuestros filósofos cometieron un grave error: sin investigar la esencia de las cuestiones, empezaron a negar la importancia de la nueva dirección de la ciencia principalmente por el bombo sensacionalista que se levantó en el extranjero en torno a esta dirección, porque algunos periodistas burgueses ignorantes se dedicaron a la publicidad y a la especulación barata en torno a la cibernética, y las figuras reaccionarias hicieron todo lo posible para utilizar la nueva dirección de la ciencia en sus intereses reaccionarios de clase. Es posible que la intensificación de la interpretación reaccionaria e idealista de la cibernética en la literatura reaccionaria popular se haya orquestado deliberadamente para desorientar a los científicos e ingenieros soviéticos, con el fin de frenar el desarrollo del nuevo e importante campo científico en nuestra prensa.

Hay que señalar que al autor de la cibernética N. Wiener se le atribuyen sin razón las declaraciones en la prensa sobre la hostilidad fundamental de los autómatas hacia el hombre, sobre la necesidad de sustituir a los trabajadores por máquinas, así como sobre la necesidad de extender las disposiciones de la cibernética al estudio de las leyes del desarrollo social y de la historia de la sociedad humana.

De hecho, N. Wiener, en su libro Cibernética (N. Wiener «Cybernetics». N. Y. 1948), dice que en una sociedad capitalista, en la que todo se valora con dinero y domina el principio de la compraventa, las máquinas pueden traer daño, no bien, al hombre.

Además, Wiener escribe que en un mercado capitalista caótico, el desarrollo de la automatización conducirá a una nueva revolución industrial que hará superfluas a las personas con capacidades intelectuales medias y las condenará a la extinción. Y aquí Wiener escribe que la solución está en la creación de otra sociedad, una sociedad en la que la vida humana se valore en sí misma y no como objeto de compra y venta.

Por último, Wiener se muestra muy cauto en cuanto a la posibilidad de aplicar la cibernética al estudio de los fenómenos sociales, argumentando que aunque una serie de fenómenos y procesos sociales pueden ser estudiados y explicados en términos de teoría de la información, en la sociedad humana, además de los factores estadísticos, actúan otras fuerzas que no son analizables matemáticamente, y los períodos de la sociedad en los que existe una relativa estabilidad necesaria para aplicar los métodos de investigación estadística son demasiado cortos y escasos

Cabe señalar que la Cibernética de Wiener contiene una aguda crítica a la sociedad capitalista, aunque el autor no indica una salida a las contradicciones del capitalismo y no reconoce una revolución social.

Los filósofos y escritores reaccionarios extranjeros tratan de explotar la cibernética, como cualquier nueva tendencia científica, para sus propios intereses de clase. Al publicitar enérgicamente y a menudo exagerar las declaraciones de científicos cibernéticos individuales sobre los logros y las perspectivas de la automatización, los periodistas y escritores reaccionarios están cumpliendo la orden directa de los capitalistas de adoctrinar a la gente común para que piense que es inferior, que los trabajadores comunes pueden ser reemplazados por robots mecánicos y, por lo tanto, buscan menospreciar la actividad de las masas trabajadoras en la lucha contra la explotación capitalista.

Debemos denunciar con decisión esta manifestación de una ideología hostil. La automatización en una sociedad socialista sirve para facilitar el trabajo humano y hacerlo más productivo.

También debemos luchar contra la vulgarización del método de la analogía en el estudio de la actividad nerviosa superior, rechazando las interpretaciones simplistas y mecanicistas de estas cuestiones y estudiando cuidadosamente los límites de aplicabilidad de los modelos y diagramas electrónicos y mecánicos para representar los procesos de pensamiento.