Max Grünberg

Resumen

En el marco de un discurso más amplio sobre la planificación económica, este artículo cuestiona críticamente los retos prácticos que plantea la aplicación de algoritmos de optimización para lograr la eficiencia en la asignación de recursos a escala de las economías nacionales. Al cuestionar si la tecnología de la información contemporánea resuelve las deficiencias de la planificación de mando soviética, el documento ofrece una introducción histórica a la planificación óptima y aborda cuatro problemas fundamentales a los que se enfrentarían los planificadores óptimos, a saber: la preocupación por la complejidad computacional, el reto de generar los datos económicos necesarios para la constitución de un sistema de este tipo, la cuestión de conciliar un óptimo estático con el dinamismo de las economías reales y, en última instancia, la relación de los solucionadores de optimización con una jerarquía de fines. Además de las preocupaciones epistémicas, el mayor riesgo de un marco de planificación de este tipo lo constituye la posibilidad de un lento descenso hacia un sistema autoritario que reflejaría la experiencia soviética por su dependencia de las instituciones burocráticas para hacer funcionar esta máquina.

Introducción

Lo más tonto es no calcular. La segunda cosa más tonta es seguir ciegamente los resultados de tus cálculos”

– Michal Kalecki

Desde la concepción de la disciplina, la economía se ha entendido como el medio racional de identificar el mejor uso de recursos escasos entre fines contrapuestos, independientemente de si se trata de la supervivencia de Robinson, la prosperidad de la propia familia, la riqueza de las naciones, una armonía igualitaria o simplemente la generación de beneficios individuales. Sin duda, los medios y los fines descubiertos en este proceso, antes denominado “economía política”, pueden diferir fundamentalmente. No obstante, la historia nos revela sorprendentes solapamientos de técnicas que atraviesan las líneas de sistemas económicos opuestos, lo que proporciona alguna prueba empírica del carácter universal o de una relación esencial de los problemas económicos, incluidas sus posibles soluciones, o al menos desvela un tipo específico de racionalización económica que está en juego en las diferentes culturas −en caso de que uno prefiera un punto de vista más constructivista.

Uno de estos métodos es la optimización matemática. Hoy en día, todas las empresas de éxito utilizan algún tipo de algoritmo de optimización en los procesos de planificación interna, ya sea para programar la cadena de suministro, para determinar la distribución de los almacenes, la ruta de la flota de carga o para el uso óptimo de la maquinaria. Pero, ¿puede aplicarse una tecnología de este tipo, que ha demostrado su eficacia a nivel empresarial, para funcionar en beneficio de los trabajadores dentro de una sociedad postcapitalista que planifica colectivamente la producción? Para muchos observadores críticos, esos algoritmos se agrupan con otras tecnologías de gestión algorítmica y parecen simplemente ser la causa de la alienación al intensificar el trabajo. Sin embargo, un sistema económico que desee reducir las horas de trabajo y evitar el colapso ecológico reduciendo el consumo de recursos, por medios distintos a la austeridad, también tendría que ocuparse de cuestiones como el uso óptimo de los recursos. De ahí también que el reto coordinativo de un modo de producción socialista siga siendo trascender la asignación mediante el mecanismo de los precios con una forma más racional de distribuir los recursos escasos. Lo que está en juego es si los enfoques matemáticos pueden ayudar en la coordinación de los flujos materiales para hacer realidad un futuro postcapitalista.1

Para entender mejor este reto fundamental y comprender por qué hoy en día se habla de algoritmos de optimización, puede ser útil conceptualizar la economía como una búsqueda de la eficiencia en la asignación de recursos para lograr la mayor satisfacción posible de las necesidades. Por supuesto, este espacio de búsqueda está restringido por limitaciones naturales y sociales y tiene una dimensión dinámica y otra estática. A pesar de su interdependencia práctica, se puede pensar que la dinámica se refiere mucho más a la incertidumbre de los cambios futuros, mientras que la estática se vincula más al estado actual de la economía. Un breve ejemplo puede ilustrarlo mejor. Supongamos que una economía tiene capacidad para producir un millón de unidades de un determinado microprocesador, pero la demanda total supera esta cantidad. Llegados a este punto, la decisión de planificación dinámica podría consistir en aumentar la oferta o desarrollar un nuevo tipo de chip, lo que exigiría invertir en nuevos bienes de capital, como máquinas litográficas. Si no se quiere entregar estas decisiones de inversión al mercado y a la especulación financiera, ni a los burócratas, sino socializar la función de inversión, esta economía requeriría lo que Aaron Benanav (2020) denomina “protocolos de planificación” democráticos, o lo que Maxi Nieto (2021) denomina “consejos de inversión”. Sin embargo, para implementar esto, aún se requerirán decisiones asignativas en el presente que en muchos casos tendrán lugar bajo escasez. Los recursos necesarios para una nueva planta de fabricación de semiconductores también podrían demandarse en otros lugares de la economía y es probable que los factores limitantes no permitan satisfacer todas las demandas productivas.2 Lo mismo cabe decir de nuestros procesadores. Hasta que se aumente la producción para satisfacer la demanda, nos enfrentaremos a un estado de escasez, que requerirá de nuevo decisiones sobre cuál es la mejor forma de asignar este bien escaso. Mientras que en su oposición al capital financiero parece existir un amplio consenso entre los socialistas sobre los aspectos dinámicos de la planificación hacia la democratización de la función de inversión, el mayor desacuerdo se encuentra a la hora de resolver este problema de asignación estática, que se reduce a la cuestión de quién obtiene qué en la economía en un momento dado.3

Hasta ahora, nuestro espacio imaginativo parece limitarse a cinco trayectorias generales para abordar el aspecto estático de la eficiencia distributiva. La primera trayectoria para resolver este problema es el statu quo del orden de mercado. Se trata del mecanismo de precios aún presente en las propuestas socialistas de mercado, que dirige el flujo de recursos escasos en la dirección de las empresas más rentables. Como punto de partida, esto es lo que los socialistas aún dedicados a la idea de un plan económico desean trascender. En segundo lugar, a raíz de la planificación dirigida soviética, estas decisiones de asignación podrían ser retomadas por los burócratas. Marx lo llamó despectivamente el “papado de la producción”, y −después de la experiencia del socialismo realmente existente− cualquier retorno al despotismo económico parece presentar la alternativa menos deseable. En tercer lugar, como inversión de tal centralismo burocrático, se podría acordar conceder a los productores inmediatos el control total sobre la asignación de los productos de su trabajo, lo que equivaldría a una dictadura igualmente irracional de la periferia, o a un anarquismo sin mercados, debido a sus intereses particulares y a su conocimiento limitado de las necesidades de la sociedad. Una cuarta trayectoria, favorecida por la mayoría de los antiautoritarios actuales, consistiría en resolver este problema mediante un proceso de negociación deliberativa en el que participasen todos los afectados para alcanzar un consenso. Basada en principios voluntaristas, es la creencia utópica de que la eficiencia distributiva de una economía mundial emanaría armoniosamente de la multitud. En una forma ligeramente más burocrática, esta esperanza se articula hoy en el llamamiento de Pat Devine (1988) a la coordinación negociada. Incluso en el improbable caso de que pudiera alcanzarse un consenso sobre la asignación de millones de bienes escasos entre los participantes4 por medios horizontales con una miríada de reuniones celebrándose simultáneamente, cada decisión individual de asignación tendría efectos en cascada dentro de la economía que darían lugar a un bucle recursivo de renegociación permanente, que paralizaría la economía en un estado inconcluso y reforzaría los llamamientos desesperados a un racionamiento por precios o jerarquías burocráticas para resolver los conflictos persistentes. Finalmente, el quinto y último recurso que parece tener la humanidad para hacer frente a la complejidad de esta tarea de asignación es alguna forma de mediación algorítmica.

En un intento de ofrecer algunas respuestas sobre el potencial emancipador de dicha coordinación algorítmica, el siguiente artículo comienza con una primera parte en la que se ofrece una introducción histórica a la planificación óptima, al tiempo que se esboza brevemente la planificación de mando soviética clásica y sus deficiencias. En la segunda parte se abordan las propuestas más recientes de aplicar algoritmos de optimización para resolver la búsqueda socialista de eficiencia en la asignación de recursos y se esbozan cuatro problemas fundamentales a los que se enfrentarían los planificadores óptimos, a saber: el problema de la complejidad computacional, el reto de generar los datos económicos necesarios para la constitución de un sistema de este tipo, la cuestión de conciliar un óptimo estático con el dinamismo de las economías reales y, por último, la relación de los solucionadores de optimización con una jerarquía de fines, cuestionando si un marco de planificación óptima de este tipo podría ser capaz de superar tanto los problemas económicos como políticos del sistema soviético.

Optimización a ambos lados del Telón de Acero

El primer algoritmo de optimización para la planificación de la producción fue formulado por el matemático Leonid Kantorovich (1960) en 1939, en el contexto de la industrialización soviética, cuando Plywood Trust [una empresa de madera contrachapada] se puso en contacto con él en busca de ayuda para maximizar su producción con el fin de alcanzar el objetivo de su plan. Dada la información sobre la productividad de ocho máquinas peladoras para cinco tipos diferentes de madera y un plan de surtido que especificaba las proporciones de los productos, el problema de optimización consistía en identificar el mejor uso posible para cada máquina. Lo que antes resolvían maquinistas y gestores, ahora lo calculaba Kantorovich con una novedosa técnica de optimización computacional. Un elemento central de su método de “resolución de multiplicadores” era el cálculo de los costes de oportunidad, que más tarde denominó “valoraciones determinadas objetivamente”, que indican qué combinación de gasto de materiales y mano de obra aplicar para lograr una producción óptima. Como señala Roy Gardner (1990: 643) “la idea económica fundamental de Kantorovich” era que un “plan óptimo es inseparable de sus precios”. Desde sus comienzos en el Plywood Trust [compañía de madera contrachapada], Kantorovich comprendió el potencial que esta técnica tenía para todo el aparato de planificación soviético, ya que sus valoraciones determinadas objetivamente funcionan de forma similar a los precios monetarios al permitir a los agentes económicos sobre el terreno comparar los costes de oportunidad o las consecuencias económicas de diferentes métodos de producción con respecto a la optimalidad global del sistema. Así, en teoría, permite una forma de planificación in natura al hacer posible precisamente el análisis coste-beneficio o la indagación de las relaciones de sustitución que Ludwig von Mises había afirmado en el advenimiento del debate sobre el cálculo socialista que era imposible en ausencia de un mercado.

Sin embargo, en las circunstancias políticas imperantes en aquel momento, Kantorovich dudó en un principio a la hora de difundir sus ideas. Esto se debió a que, tras el estallido de la Segunda Guerra Mundial y con el telón de fondo de la Gran Purga, temía que su trabajo pudiera ser utilizado fuera del país (Kantorovich, 1987: 256) y, por tanto, correría el riesgo de verse implicado en “tendencias contrarrevolucionarias”, debido a la proximidad de su propuesta con el concepto burgués de coste de oportunidad unido a la aversión general de los planificadores estalinistas en aquella época a aplicar las matemáticas al campo de la economía. No obstante, convencido de su valor práctico para la economía soviética, pronto empezó a presionar con cautela para que sus ideas se aplicaran más ampliamente en la optimización de los procesos de planificación a mayor escala. Tras ser rechazado por el Gosplan, la principal comisión estatal de planificación, durante la Segunda Guerra Mundial interrumpió por el momento su campaña, en parte por su propia seguridad (muchos han sido deportados o ejecutados por menos), pero también para poner sus habilidades matemáticas a disposición del esfuerzo bélico de la patria.5

Mientras tanto, al otro lado de lo que pronto se convertiría en el Telón de Acero y sin ningún conocimiento del trabajo previo de Kantorovich, George Dantzig, un matemático igualmente dotado, se inspiró en los problemas logísticos militares de la Segunda Guerra Mundial para desarrollar un método de optimización similar en 1947 bajo el paraguas de la Investigación de Operaciones de las Fuerzas Aéreas del Ejército,6 que se convertiría en el método fundacional de lo que hoy se conoce como programación lineal en Occidente. Después de que William Orchard Hays escribiera el primer software comercial para resolver programas lineales en 1954 mientras trabajaba en la RAND Corporation, el “método simplex” de Dantzig se convirtió en una parte esencial de la producción capitalista al ofrecer soluciones a los problemas de rutas y programación en la planificación de la producción. En las décadas siguientes, la adaptación de los esquemas de programación lineal y otras formas de optimización matemática se extendió a todos los rincones del mundo comercial.

Irónicamente, en pleno auge del miedo rojo de Joseph McCarthy, ciertas personas implicadas en el desarrollo de soluciones matemáticas para problemas económicos, a menudo procedentes directamente del Complejo Militar−Industrial−Académico estadounidense, se atrevieron a expresar pensamientos similares a los de Kantorovich en cuanto a ampliar la aplicación de algoritmos para coordinar economías enteras. Por ejemplo, en la introducción a las actas de la primera conferencia sobre programación lineal celebrada en la Cowles Commission for Research in Economics en 1949, el organizador Tjalling Koopmans7 intervino en el debate sobre el cálculo socialista afirmando:

El problema de la producción eficiente se convierte entonces en el de encontrar las reglas adecuadas para combinar estos bloques de construcción. […] A los argumentos de Mises sobre la inmanejabilidad de los problemas de cálculo de la asignación centralizada, los autores oponen las nuevas posibilidades abiertas por los modernos equipos informáticos electrónicos. (Koopmans, 1951: 6−7)

Ahora bien, no sólo Koopman, sino también varios científicos socialistas de instituciones de investigación occidentales se comprometieron seriamente con la idea de la ingeniería de la economía en aquella época. Hasta cierto punto, el Pentágono incluso trató ese enfoque informatizado de las asignaciones económicas como una amenaza y como una alternativa potencialmente viable a una economía de mercado capitalista guiada por señales de precios. En un informe clasificado de la CIA sobre el libro de Leonid Kantorovich The Best Use of Economic Resources [El mejor uso de los recursos económicos] (1965), que publicó originalmente en ruso en 1959, tras la muerte de Stalin y el comienzo de la “desestalinización”, para popularizar sus ideas, el clarividente revisor concluyó que:

este libro es excepcionalmente significativo por la contribución que puede hacer a la teoría económica soviética y a la práctica de la planificación en la medida en que sea aceptado. Si se aplicaran plenamente los conceptos y metodologías de Kantorovich, tendría que producirse algún cambio en el centro del poder económico −algo improbable. No es probable que los intereses creados soviéticos, ya sean funcionarios del partido, gestores o planificadores, renuncien al control sobre las multitudinarias decisiones económicas tomadas en los estratos intermedios de la economía soviética. (CIA, 1960: 5)

Para el aparato de seguridad estadounidense, la programación matemática se consideraba una parte esencial de lo que se percibía como la adopción soviética de la teoría cibernética y un plan más amplio para desarrollar una “Red de Información Unificada” (Conway y Siegelman, 2005: 318), para lo cual la agencia abrió “una rama especial para estudiar la amenaza cibernética soviética”. En 1962, el principal asesor del presidente Kennedy advirtió de que el “compromiso total soviético con la cibernética” daría a los soviéticos “una ventaja tremenda” y que “para 1970 la URSS podría tener una tecnología de producción radicalmente nueva, que implicaría empresas o complejos industriales totales, gestionados por un control de retroalimentación de bucle cerrado que emplearía ordenadores autodidactas”. Si continuaba la negligencia estadounidense hacia la cibernética, concluía, “estamos acabados” (citado por Gerovitch, 2008: 336). Sin embargo, tales preocupaciones eran injustificadas, ya que una red de información para informatizar el proceso de planificación y sobrescribir el proceso de planificación de balance de materiales predominantemente analógico y en gran medida desinformado con un marco de planificación unificado que utilice técnicas de optimización matemática al final nunca se materializó en la Unión Soviética. En su lugar, se quedaría sólo en una visión futurista o en un telón de fondo amenazador de la Guerra Fría.

El sistema soviético

La planificación de mando soviética clásica8 constaba de tres niveles: en la cúspide reinaba el Gosplan, responsable de aplicar los objetivos políticos del Politburó en relación con los objetivos del plan para las industrias clave y de garantizar la coherencia del plan de producción nacional para los bienes clave altamente agregados. Inmediatamente por debajo del Gosplan estaban los ministerios de industria, encargados de vincular el centro y la periferia desglosando las instrucciones agregadas que transmitía la comisión central de planificación para distribuir el objetivo de producción entre las ramas de la industria bajo sus auspicios, y de agregar los informes de las empresas en sentido ascendente. En la base se encontraban las empresas individuales responsables del cumplimiento de los objetivos obligatorios del plan. En determinados periodos se crearon diferentes organismos intermedios −desde los Sovnarkhozy hasta las asociaciones (véase Gorlin, 1974)− que se situaban entre las empresas y los ministerios en la jerarquía de la planificación.

A pesar del carácter jerárquico de este proceso de planificación, era el Gosplan quien elaboraba el plan nacional de producción y distribución, garantizando al mismo tiempo el equilibrio material entre insumos y productos; y aún las empresas podían influir en el plan enviando contrapropuestas a los niveles superiores de la cadena de mando. Una vez que el centro asimilaba la información que le llegaba desde abajo, el procedimiento de planificación pasaba por varias rondas de iteración. Sin embargo, en cualquier caso, las empresas estaban sujetas a las instrucciones vinculantes de los burócratas de planificación y tenían poco margen de autodirección, ya que sus superiores dominaban tanto lo que debían producir como los materiales con los que debían alcanzar sus objetivos de producción, ya que los productores tampoco tenían mucha influencia a la hora de elegir a sus proveedores. Dirigida por gerentes nombrados por el partido, la organización interna del lugar de trabajo reflejaba la forma piramidal del aparato de planificación soviético. La democracia en el lugar de trabajo o en la economía en general era de facto inexistente.

Mientras que la estructura competitiva del mercado tiende a la sobreproducción, lo que da lugar a un mercado de compradores, donde los clientes se encuentran idealmente en la situación beneficiosa de elegir entre proveedores, la economía soviética era una economía de escasez (Kornai, 1980), una dictadura del proveedor, donde los clientes sólo tenían la Elección de Hobson de tomar lo que se les asignaba o dejarlo. Aunque no existían vínculos horizontales oficiales entre las empresas sin la mediación de los superiores burocráticos, el resultado de las malas asignaciones crónicas era la aparición de una zona gris informal, tolerada por los funcionarios, en la que los agentes proveedores de las empresas regateaban directamente entre sí utilizando los recursos asignados que no utilizaban para conseguir los insumos necesarios para su unidad de producción. En este sistema, la mayoría de los cálculos económicos y las asignaciones de recursos se realizaban predominantemente en términos físicos. Aunque existían precios, éstos no eran determinados por las fuerzas del mercado, sino por las autoridades centrales. Así pues, los índices de valor tenían menos una finalidad asignativa que una “función de control y evaluación” (Bornstein, 1962: 66). Sin embargo, incluso esta última función apenas tuvo consecuencias para la economía en general, ya que la ineficacia del sistema se intensificó aún más debido a la falta de mecanismos para eliminar a los productores improductivos o superfluos mediante la quiebra: las empresas soviéticas funcionaban con una “restricción presupuestaria blanda”, lo que significaba que las pérdidas de las empresas individuales eran “pagadas por alguna otra institución, normalmente el Estado” (Kornai, 1986: 4) y los directivos responsables solían conservar sus puestos independientemente de los resultados.

El problema sistémico de la escasez se vio agravado por el exceso endémico de inversión inherente a la economía soviética, un hambre de inversión provocada por los objetivos excesivamente ambiciosos de los planes de la dirección política, la insostenible priorización del ejército y la industria sobre las necesidades de los consumidores, así como la construcción del imperio de los ministerios sectoriales y regionales, todo lo cual condujo a la fragmentación de las inversiones y a grandes retrasos en la finalización de los proyectos. Este defecto crítico de escasez crónica no sólo tuvo efectos cuantitativos, como el tiempo de inactividad no planificado en la fabricación debido a la “holgura improductiva” (Kornai, 1980: 103), sino que también redujo la calidad general de los bienes disponibles. Apenas había consecuencias para los productores por suministrar bienes de calidad inferior o productos con especificaciones para las que no había demanda. Además, se desincentivaba el pensamiento a largo plazo, y lo que importaba en su lugar era el cumplimiento a corto plazo de los objetivos del plan trimestral. En general, la reacción de los consumidores era muy disfuncional en la Unión Soviética, sobre todo los consumidores finales. Una producción aparentemente desvinculada de las necesidades de los consumidores, junto con un sistema de precios disfuncional, condujo a una realidad económica de grandes existencias de productos sobrevalorados y largas colas en los mercados negros cuando estaban con precios bajos.

Otro grave problema del sistema era que el centro no era capaz de procesar información desagregada, por lo que necesitaba a los ministerios de nivel medio como interfaz. Una de las consecuencias más conocidas fueron los indicadores de objetivos agregados que se transmitían a las empresas, lo que creaba incentivos perversos. En ausencia de canales de retroalimentación funcionales y sin más especificaciones, los objetivos de producción física crearon curiosas distorsiones de las necesidades de los consumidores debido a la manipulación estratégica de los directores de fábrica para burlar el sistema. Entre las innumerables historias de este tipo, una anécdota popular es la fabricación de clavos soviéticos, cuyo tamaño era diminuto cuando el objetivo del plan se expresaba en una determinada cantidad de piezas demandadas, o enorme cuando se articulaba en toneladas. Otro problema de incentivos era que los productores disimulaban sus capacidades productivas para cumplir más fácilmente sus objetivos del plan, y también inflaban sus necesidades de insumos para asegurarse de que se les asignaban las cantidades necesarias. La incertidumbre general de la oferta para los productores provocó más ineficiencias, como el acaparamiento de grandes existencias, así como la producción interna de componentes críticos, lo que dio lugar a fábricas menos especializadas y a una disminución de la eficiencia general.

En última instancia, la planificación soviética se basaba en la idea de los balances de materiales para garantizar la coherencia del plan. Para que un plan fuera “viable” bastaba, en primer lugar, con que los recursos utilizados en el plan estuvieran realmente disponibles y, en segundo lugar, con que la producción de los proveedores coincidiera con la de los demás productores, es decir, que hubiera coherencia entre insumos y productos en toda la economía. En teoría, esto se conseguía con los balances de materiales, pero en la práctica el centro se veía desbordado por la tarea, ya que los datos proporcionados no eran muy fiables, carecían de la información crucial de la disponibilidad de recursos, y los planificadores centrales se quedaban a menudo rezagados, incapaces de procesar los datos disponibles con la suficiente rapidez debido a sus limitaciones burocráticas basadas en el estado abrumadoramente analógico de la infraestructura de planificación. Por ello, los órganos centrales tenían que formular sus planes utilizando categorías gruesas, lo que daba lugar a molestos errores de agregación: si bien el plan nacional de producción y distribución podía ser equilibrado en términos agregados, era incoherente a nivel desagregado, por lo que el plan debía modificarse periódicamente para corregir los errores consiguientes a lo largo del año. Pero incluso si el centro hubiera sido capaz de formular un plan factible en términos desagregados para la economía nacional mediante balances materiales, esto no le habría permitido determinar si podría ser bueno o incluso el mejor. Es en este entorno, en el que ciertos científicos soviéticos esperaban mejorar este proceso de planificación mediante métodos matemáticos de optimización, a veces también denominados “cibernética económica” o “planometría” (Zauberman, 1962), cuya aplicación Kantorovich enmarcó en lo siguiente:

el sistema de planificación óptima no presupone en absoluto la plena centralización de las decisiones económicas. Al contrario, gracias a que junto con el plan económico nacional se elabora un sistema de precios y valoraciones (normas de producción/capital, renta de la tierra y de los recursos naturales, normas de eficacia de las inversiones, etc.) coherente con él, surge la posibilidad de tomar localmente decisiones lo más coherentes posible con los intereses de la economía nacional. Esto favorece la amplia utilización de las iniciativas de los colectivos económicos, la posibilidad de movilizar recursos y descubrir reservas a nivel local, permite la expansión de los derechos de las unidades económicas separadas y la construcción de un sistema de valoraciones y estímulo del trabajo de las unidades separadas, de tal manera que lo que es rentable para la sociedad en su conjunto, también lo es para cada empresa. En otras palabras, tal sistema crea la base teórica para la solución del problema de la combinación de la gestión centralizada de la economía con amplios derechos e iniciativa a nivel local sobre la base de métodos económicos de control. (Citado por Ellman, 1968: 117)

Aunque la programación matemática asumiría necesariamente un papel central en este procedimiento, sus defensores comprendieron bien que tales algoritmos no resolverían todos los problemas mencionados y que, por el contrario, tendrían que introducirse junto con mecanismos de mercado y otras reformas que democratizaran el proceso de planificación. Así pues, a pesar de la percepción del dominio tecnocrático de las matemáticas aplicadas sobre los asuntos económicos, estos teóricos de la planificación creían de hecho que su enfoque permitiría en última instancia aumentar la autonomía de la periferia.

Esta convulsión discursiva de la planificación óptima a partir de la investigación operativa a nivel empresarial surgió a raíz del movimiento cibernético soviético, que proporcionó un lenguaje filosófico más amplio, pero también un impulso material hacia la conexión en red del país. La cibernética, que inicialmente había sido rechazada como pseudociencia reaccionaria por Stalin, fue rehabilitada tras su muerte por figuras influyentes como el pionero cibernético Anatoly Kitov y pronto se convirtió en doctrina estatal bajo la visión de Nikita Khrushchev de automatizar la economía. Sin embargo, las ambiciones de conectar en red el aparato de planificación mediante infraestructuras informático-tecnológicas (hardware) y de aplicar modelos matemáticos, así como las reformas necesarias (software) a escala nacional, acabaron fracasando por falta de voluntad política. Desde finales de los años cincuenta hasta principios de los setenta, la cibernética económica adquirió una gran popularidad, encabezada por el programa de investigación “Sistema para el Funcionamiento Óptimo de la Economía” (SOFE), dirigido por Nikolai Federenko y Vasily Nemchinov, que incluía varios intentos de crear redes nacionales de información, sobre todo el “Sistema Automatizado de Todo el Estado” (OGAS) ideado por el cibernético Victor Glushkov.9 No obstante, todos estos intentos se toparon con una fuerte resistencia por parte tanto de los reformistas del mercado como de las fuerzas conservadoras de los administradores comprometidos con el statu quo, que comprendían perfectamente que la introducción con éxito de dicha tecnología supondría una pérdida de su poder o incluso podría dejarlos obsoletos. Muchos proyectos locales de ambiciosos planificadores óptimos fracasaron porque los ministerios simplemente no facilitaron los datos estadísticos pertinentes. Ya en 1961 el economista polaco Oskar Lange compararía la situación del planometrista soviético con “un químico al que se le niega el acceso a su laboratorio o a un astrónomo al que se le impide observar el cielo” (citado en Smolinski, 1973: 1190). Otro factor importante que influyó en que la planificación óptima nunca se aplicara a gran escala en la Unión Soviética fue el escepticismo justificado sobre la viabilidad de la potencia de cálculo disponible en aquel momento, unido a los astronómicos costes de inversión que conllevaba la realización de esta visión. El riesgo de fracaso era sencillamente demasiado alto, y las reformas liberales del mercado llegaron con la promesa de ser la opción menos arriesgada.

La aplicación más amplia de la planificación óptima en la Unión Soviética la realizó el propio Kantorovich en 1970, al optimizar la programación de la producción de la industria siderúrgica, abordando cerca de “1.000.000 de pedidos, con 60.000 usuarios, más de 500 productores y decenas de miles de productos”. Tras recopilar los datos necesarios durante seis años, Kantorovich formuló la optimización de los calendarios de producción y los planes de acoplamiento como un programa lineal con “más de un millón de incógnitas y 30.000 restricciones”, con un ahorro real de acero tras su aplicación de “sólo 108.000 toneladas, aunque el ahorro calculado era de 200.000 toneladas” debido a la imperfección de la información. Sin embargo, resultó

que el uso de ordenadores en la planificación de la industria siderúrgica tenía una gran ventaja, además de aumentar la producción al aprovechar mejor la capacidad productiva. Permitía reducir el grado de agregación de las necesidades durante el proceso de planificación y, por tanto, la divergencia entre la producción y las necesidades. (Ellman, 1973: 72-75)

Antes del colapso de la Unión Soviética ha habido una variedad de proyectos de este tipo, aunque casi ninguno de sus defensores ha llegado tan lejos como para optimizar la economía dentro de un modelo único, una esperanza que fue “apodada computomanía por sus oponentes” (Gardner, 1990: 646). János Kornai, por ejemplo, que desarrolló y aplicó métodos de planificación óptima en nombre del gobierno socialista húngaro y se fue desilusionando con la perspectiva de una planificación económica eficiente a través de su experiencia en las trincheras del sistema de planificación de estilo soviético, declaró ya en 1970 que es “una idea de ciencia ficción cubrir todos los problemas relevantes de un sistema económico en un único modelo” debido a la enorme cantidad de variables y ecuaciones, abogando en su lugar por “un sistema unido de modelos” (Kornai, 1970: 14-15).10 Del mismo modo, en un último suspiro antes de morir en 1986, también para Leonid Kantorovich el objetivo final de su visión seguía siendo no la formalización de un único modelo, sino la creación de

un complejo único de modelos interconectados que abarcan toda la economía nacional, así como sistemas de previsión, planificación y gestión centralizada y descentralizada de la economía nacional que ofrecen a los trabajadores y a los gestores de los distintos niveles y sectores de la economía amplias oportunidades para desplegar su iniciativa. (Kantorovich et al., 1987: 17)

Además de la complejidad y enormidad del problema en cuanto a la cantidad de variables que hablan en contra de un modelo singular, también resultó difícil derivar una función objetivo para la economía en su conjunto. Una cosa es maximizar la producción de una fábrica de contrachapado en las proporciones adecuadas o minimizar el consumo de material en la industria siderúrgica, pero ¿con qué criterio se debe optimizar toda la economía? ¿Cuál sería el criterio de tal optimalidad? Ha habido un intenso debate sobre esta cuestión en la literatura soviética, que Alec Nove resume en los siguientes términos:

Los objetivos generales de política económica del partido son demasiado generales, demasiado difusos, para servir de criterio operativo. Si la dirección le pide que elabore un programa que contenga objetivos óptimos para el año 2000, la profesión económica no puede escapar al problema tomando como criterio de optimización los objetivos adoptados por la dirección. Al fin y al cabo, ¡los dirigentes piden consejo a los economistas sobre cuáles deben ser esos objetivos! ¿Cómo distinguir los medios de los fines? Se barajan varias propuestas: maximizar la renta nacional; maximizar la productividad laboral; minimizar los costes para un conjunto determinado de productos; etc. Maximizar el bienestar humano es demasiado vago, y los especialistas soviéticos más inteligentes nunca olvidan que algunos aspectos del bienestar (ocio, calidad de vida, medio ambiente, etc.) no figuran en las estadísticas de la renta nacional. Pero en el caso soviético, incluso la parte puramente material del bienestar queda mal reflejada en las estadísticas agregadas. […] Toda la noción de que alguien defina una función objetivo descansa en el supuesto incorrecto de que sólo hay un actor. (Nove, 1991: 101)

Iniciada por las Reformas Liberman en 1965, la victoria de las reformas descentralizadoras del mercado se consideró completa cuando la perestroika de Gorbachov puso el último clavo en el ataúd de cualquier intento de coordinación algorítmica a escala nacional. Y con el consiguiente colapso de la Unión Soviética, la investigación sobre la planificación óptima se detuvo abruptamente. Sin embargo, como nunca llegó a aplicarse plenamente en la Unión Soviética, queda abierta la cuestión de si la evaluación sería diferente con la tecnología contemporánea al alcance de la mano. Pero, ¿son suficientes hoy en día nuestros medios técnicos para permitir al centro planificar de forma desagregada y realizar un plan de producción y distribución matemáticamente optimizado y, en caso afirmativo, resolvería esto las deficiencias del sistema soviético antes mencionadas, especialmente en lo que se refiere a la satisfacción de los consumidores y la autonomía de los trabajadores?

El retorno de la planificación óptima y su complejidad computacional

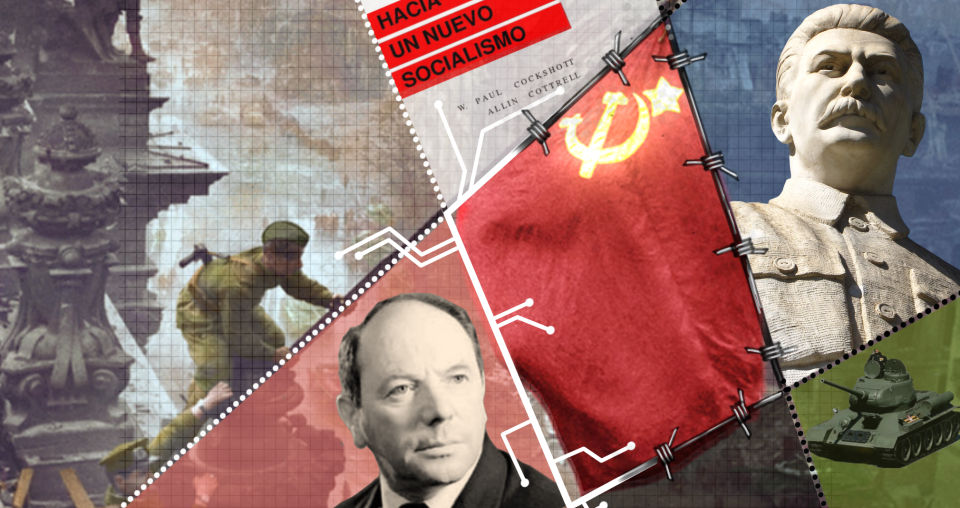

Mientras que muchos planometristas como János Kornai dieron la espalda a la planificación óptima tras la implosión de la Unión Soviética, la antorcha fue recogida posteriormente por los marxistas occidentales Paul Cockshott y Allin Cottrell en su influyente libro Hacia un Nuevo Socialismo publicado en 1993, donde desarrollaron un modelo de planificación cibernética que sustituye la programación lineal clásica por un “algoritmo de armonía” más eficiente, que sentó las bases para el resurgimiento discursivo del uso de algoritmos para la coordinación económica de los flujos de materiales. En su simplicidad, esta concepción más bien mecanicista de la economía prevé que el problema de la asignación socialista se resuelva dentro de un modelo unificado consistente en un conjunto de gigantescas matrices de insumo−producto en términos desagregados que proporcionan información sobre los métodos de producción en relación con un vector objetivo, es decir, el objetivo del plan para los bienes de consumo final. Lo que finalmente se optimiza en el modelo es el cumplimiento del plan o, en otras palabras, la armonía de la oferta y la demanda. Esto se consigue matemáticamente mediante una función objetivo singular (es decir, el algoritmo de la armonía), sujeta a un conjunto de restricciones, que minimiza la desviación de la producción final con respecto al objetivo inicial del plan para los bienes de consumo final. Como resultado de este proceso de optimización, se obtiene un plan de asignación detallado para toda la economía.11 Su decisión a favor de una única función objetivo se basa en el supuesto de que la tecnología de la información contemporánea permitiría que el proceso se desarrollara en términos desagregados, lo que constituye una diferencia crucial en comparación con la situación de escasez de estadísticas agregadas a la que se enfrentaban los planificadores soviéticos. En teoría, esto permitiría que las decisiones detalladas de asignación ya no fueran tomadas por burócratas dotados de intereses particulares, sino por un algoritmo aparentemente objetivo. De este modo, la motivación para utilizar tales algoritmos no es sólo aumentar la eficiencia asignativa, sino también, a pesar de sus características centralistas, arrebatar el poder político que antes tenían los burócratas soviéticos y trascender la arbitrariedad de sus decisiones subjetivas a un proceso más objetivo guiado por la lógica formal.

Más recientemente, se han presentado otras propuestas que aplican el método simplex (Dapprich, 2022), el aprendizaje automático (Samothrakis, 2021) o el algoritmo del punto interior (Härdin, 2021b) para su optimización.12 En cuanto a su viabilidad técnica, estos cálculos algorítmicos se apoyan en un doble reto. En la literatura, esto se suele entender como las dos partes del “problema del conocimiento” de Friedrich Hayek, que se puede subdividir en la cuestión de generar y la de procesar datos económicos.13 Aunque se suele atribuir a Hayek, esta última preocupación ya fue articulada por su colega Lionel Robbins en 1934, quien reconoció que el problema de la planificación socialista se podía enmarcar como un sistema de ecuaciones, pero creía que

En la práctica, esta solución es bastante inviable. Sería necesario elaborar millones de ecuaciones a partir de millones de tablas estadísticas basadas en muchos más millones de cálculos individuales. Para cuando se resolvieran las ecuaciones, la información en la que se basaban habría quedado obsoleta y habría que calcularlas de nuevo.

(Robbins, 1934: 151)

Mientras tanto, en lo que respecta a los esquemas clásicos de programación lineal, este argumento sigue siendo válido hoy en día, debido a su complejidad computacional bastante elevada. Este tiempo de ejecución de los algoritmos se diferencia en informática en clases de complejidad según la notación O grande, siendo las clases más importantes: constante O (1), lineal O (n), log-lineal O (n log n), polinómica O (nk) o exponencial O (en). Dado el mismo tamaño del insumo (n), el tiempo de ejecución de estas clases difiere sustancialmente. Los algoritmos que tienen un tiempo exponencial sólo son viables para los conjuntos de datos más pequeños, pero también los que tienen un tiempo de ejecución polinómico pueden llevar a los superordenadores contemporáneos a sus límites si la entrada [insumos] es lo suficientemente grande. Durante mucho tiempo no se supo si las técnicas de programación lineal, como el método simplex, tenían una complejidad exponencial. Hoy sabemos que, para la mayoría de los problemas, la complejidad del algoritmo simplex está dentro del tiempo polinómico, con una complejidad de aproximadamente n3. Es cierto que en los años 70 y 80 no se habría podido movilizar en la Unión Soviética una potencia de cálculo suficiente para tratar una entrada de millones de variables,14 e incluso con los medios de cálculo actuales, un algoritmo de esa complejidad sería prácticamente inviable para calcular un plan de una economía nacional en términos desagregados.

No obstante, las propuestas recientes se basan en la idea de que en las economías dinámicas no será necesaria una solución óptima, y que las aproximaciones serán probablemente suficientes para la tarea. Al sacrificar un grado de optimalidad por la viabilidad computacional, algoritmos como el algoritmo de armonía de Cockshott, que es de orden O (n log n) (Cockshott, 2019b: 314), y también el método de punto interior utilizado por Härdin (2021b), que permite calcular tamaños de entrada [insumo] de hasta varios miles de millones de variables en cuestión de horas en una sola máquina, hacen que la parte computacional del problema de conocimiento sea nula. El tiempo de cálculo se reduce aún más por el hecho de que el plan no tiene que ser recalculado en su totalidad, ya que las operaciones sólo tendrán que realizarse en las variables que han cambiado entre las iteraciones, y que dicha matriz sería muy dispersa, porque la inmensa mayoría de las entradas en dicha tabla insumo−producto tan desagregada será nula, ya que sólo una fracción de todos los productos existentes entrará alguna vez como insumo en la producción de otro bien.15 La computación distribuida permitiría que estos cálculos no se hicieran en un único centro de cálculo, sino a través de una red informática descentralizada.

Así pues, parece que el problema técnico de procesar los datos económicos es manejable, aunque los autores de una reciente crítica austriaca basada en la economía de la complejidad y la teoría de la mente de Hayek afirman lo contrario, argumentando que “el control completo de cualquier sistema complejo es imposible, debido al problema de la autorreferencia” (Moreno-Casas et al., 2022: 574-575). No obstante, tal encuadre de la complejidad computacional va mucho más allá de la cuestión técnica del cálculo numérico, que parece ser −y en esto incluso los austriacos podrían estar también de acuerdo− no la limitación crítica de tal marco económico. Lo que está en juego no es si nuestros sistemas técnicos pueden manejar la carga de datos, sino la precisión con la que se generan los datos económicos y se introducen en dicho modelo, así como la forma de volver a colocar el mapa estático sobre el territorio dinámico.

La formalización del conocimiento de la producción

Siguiendo la trayectoria de sustituir un mercado competitivo por una asignación óptima por medios algorítmicos, el reto fundamental al que se enfrenta un marco de este tipo no es el procesamiento de datos, sino la generación de información económica precisa para siquiera constituir un sistema de ecuaciones (no) lineales de este tipo. Esto debería quedar claro en cuanto cambiemos de punto de vista. Mientras que, desde la perspectiva macroeconómica del planificador óptimo, la economía aparece como una matriz, desde el punto de vista micro de los productores inmediatos sus partes deben formularse primero como lo que se denomina una “función de producción”, un plan de producción individual, que en total constituyen dicha matriz insumo−producto. Mientras que cada fila de la matriz indicaría el uso de un producto específico en diferentes industrias, cada columna constituiría un método de producción único. Tanto las recientes propuestas de planificación óptima comentadas anteriormente, que en su nivel de abstracción no abordan estas cuestiones microeconómicas con suficiente detalle, como la vaga crítica expresada por los austriacos sobre el acceso al conocimiento disperso y tácito de la producción, que no aborda los modelos en detalle, no se ocupan lo suficiente de este problema de articulación de estas funciones de producción. Esta sección pretende llenar este vacío. Hasta cierto punto, se trata de una concesión a los austriacos sin llegar a ceder a su pretensión de imposibilidad, pero podría arrojar algo de luz sobre graves problemas para los que los planificadores socialistas tendrían que encontrar respuestas.

Para fundamentar este marco de planificación óptima, cada centro de trabajo tendría que elaborar una función de producción para cada uno de sus métodos de producción, estableciendo la producción máxima obtenible a partir de un conjunto de insumos. Los componentes de dicha función de producción se denominan “coeficientes técnicos” en la literatura. En ausencia de un mercado de productores, no bastaría con expresar estas funciones de producción en términos monetarios, sino que habría que recurrir a funciones insumo−producto desagregadas para generar la información sobre la que se calcula una asignación óptima. Este nivel de detalle es necesario para que el centro no se encuentre con los mismos problemas que tuvo la Unión Soviética al tratar con datos agregados. La desagregación también resuelve gran parte de los indicadores de objetivos disfuncionales mencionados anteriormente. Ya no sería necesario fijar objetivos de producción no especificados en toneladas u otras unidades físicas. Al conceder a los productores cierto grado de libertad a la hora de decidir lo que quieren producir y permitirles elegir entre alternativas de insumos con especificaciones exactas y códigos de producción, surgiría de abajo arriba información detallada sobre la demanda total de bienes intermedios específicos. Del mismo modo, habría que generar información detallada sobre la demanda de bienes de consumo.16 Correspondería al organismo social decidir hasta qué punto estas estadísticas funcionarían entonces como objetivos de plan vinculantes para el productor responsable y por qué medios, de disciplina o incentivos, se harían cumplir en última instancia.

En cuanto al temor por la autonomía de los trabajadores, expresado por anarcocomunistas como Jasper Bernes (2020), hay que subrayar que, en principio, un proceso de optimización de este tipo no requiere ninguna forma de despotismo centralista en relación con los objetivos del plan. Funcionaría igualmente bajo la condición de dejar la decisión sobre los objetivos individuales del plan a los propios centros de trabajo. Las estadísticas funcionarían entonces en este escenario descentralizado y de alta confianza sólo como objetivos indicativos o una mera orientación sobre lo que es mejor para la economía en su conjunto. La decisión final sobre hasta qué punto se cumple esto podría depender totalmente de los productores inmediatos, definiendo la producción más alta posible que cada lugar de trabajo estaría dispuesto o sería capaz de alcanzar. Esta información podría integrarse en el sistema, bien anulando el vector objetivo en el caso de los bienes de consumo, bien introduciendo un conjunto de restricciones que representen la mayor producción posible para cada lugar de trabajo. Lo que calcularía entonces un solucionador de optimización es el mejor plan posible que no infrinja esas condiciones. Lo único que se decidiría de forma centralizada por medios algorítmicos en un escenario así sería determinar dónde habría que entregar los productos acabados. Esta cuestión central de los objetivos del plan se reduce en última instancia a si queremos vivir en una dictadura del productor o del consumidor, si se desea minimizar la coacción externa a la que se enfrenta el trabajo o arrancarle el mayor grado de riqueza material. Sin embargo, la coerción disciplinaria del trabajo que introducen los objetivos del plan y la necesidad de armonizar la autonomía de los trabajadores con otras necesidades sociales no es un problema específico de la planificación óptima, sino que se sitúa en el núcleo de un modo de producción socialista.17

Un solucionador de optimización, como el propuesto por Härdin, también permitiría a los productores sugerir configuraciones alternativas para los métodos de producción y el algoritmo elegiría entonces la alternativa de plan que fuera mejor para el sistema económico en su conjunto. De este modo, los productores locales tendrían mucha más influencia a la hora de elegir a sus proveedores, proponer diferentes alternativas de insumos e incluso clasificar sus opciones, mientras que en la Unión Soviética en la mayoría de los casos las empresas recibían cuotas de materiales según lo consideraran oportuno los superiores. Como parte de este procedimiento de descubrimiento cibernético, podrían calcularse valoraciones dinámicas similares a como las imaginó Kantorovich18 que servirían de base para futuros cálculos de costes y beneficios. A la hora de determinar las relaciones de sustitución entre componentes alternativos, estas métricas de los costes de oportunidad proporcionarían a los productores no información sobre los costes estáticos, como hacen los valores trabajo, sino información dinámica sobre la escasez relativa de bienes, similar a los precios monetarios, ofreciendo así un control mucho mayor por parte de los productores inmediatos sobre lo que realmente se les asigna en comparación con el sistema soviético. Como indicadores de los cuellos de botella, estas valoraciones desempeñarían una función central en los circuitos de retroalimentación de la economía, ya que no sólo ayudarían a los productores a realizar ajustes del plan a nivel microeconómico, sino que al mismo tiempo informarían de las decisiones de inversión a nivel macroeconómico sobre dónde ampliar las industrias. Gracias a estas valoraciones, se podría pensar que la mayor parte de la planificación podría hacerse en el centro y que gran parte del trabajo que antes hacían los ministerios subordinados al Gosplan, agregando la información ascendente y desagregando las instrucciones descendentes, sería superfluo en el momento en que el centro pudiera procesar los datos desagregados. En teoría, esto anula el argumento esgrimido por Ludwig von Mises y Friedrich Hayek sobre la importancia de disponer de valoraciones dinámicas para averiguar las relaciones de sustitución que más tarde sintetizó Don Lavoie (1985), y que se ha vuelto a plantear más recientemente en Boettke y Candela (2023) en su alegato contra el “Tecnosocialismo”, ya que a primera vista los solucionadores de optimización sí podrían crear un entorno que cultive la acción económica en lugar de controlarla por completo desde arriba concediendo a la periferia plena autonomía para cartografiar su espacio productivo. Al final, lo único que haría el centro sería determinar la combinación óptima de los planes individuales elaborados por los propios productores inmediatos.

En la práctica, sin embargo, no sería una tarea sencilla formalizar los conocimientos tácitos de producción implicados en funciones de producción detalladas. Para hacernos una idea de cómo podría ser una función de producción de este tipo para un producto específico, un ejemplo puede ser útil. Tomemos, por ejemplo, el caso de un fabricante de automóviles, cuya función de producción definiría los insumos necesarios, las cantidades exactas de las distintas piezas con especificaciones exactas hasta el último tornillo, a continuación exigiría estimaciones sobre los distintos tipos de mano de obra necesarios expresados en horas, que habría que desglosar, así como la parte de tiempo de maquinaria, cuyas tasas de amortización habría que aproximar, otros costes administrativos y gastos generales, el alquiler que supone para la fábrica, la electricidad, etcétera. Todo esto tendría que expresarse en la proporción adecuada para asignar los insumos a una cantidad específica de producción. Por lo que respecta a la producción, no se trata sólo de una unidad de automóvil, o según el grado de granularidad, de un número determinado de unidades, sino también de todos los residuos y subproductos, como las emisiones de gases de efecto invernadero, que se derivan de esta actividad productiva si se desea internalizar las externalidades, lo que plantea problemas de medición y engaño. Esto sólo se complica cuanto más heterogénea es la producción. Los coches con las mismas especificaciones pueden considerarse equivalentes, pero ¿qué ocurre con la logística, donde cada ruta es un producto único?19 ¿O cómo sería la función de producción de una universidad?

Se trata de tareas que no se realizan con tanto detalle en el capitalismo, donde las funciones de producción se utilizan sobre todo en contextos macroeconómicos y la presupuestación dentro de las empresas se realiza en términos monetarios agregados y no in natura, ya que es sencillamente innecesario, desafiante y, por tanto, demasiado costoso formalizar el conocimiento tácito de la producción de tal manera. Esta es la razón por la que ni una sola persona en un fabricante de automóviles como Volkswagen está en plena posesión del conocimiento de lo que se necesita para producir una unidad de automóvil específica, ya que los aspectos más fáciles de determinar son sin duda los insumos que se consumen directamente, en nuestro ejemplo las piezas de las que se compone un automóvil, pero para el resto de los insumos en el mejor de los casos sólo habrá estimaciones, que siempre traerán consigo el peligro de distorsión y asignación errónea. La razón de ello es que no se desea componer estas funciones de producción con respecto a la producción total, lo que podría resultar más fácil para una empresa limitándose a hacer un seguimiento de lo que entra y sale y expresándolo como una simple ecuación de insumo−producto. De este modo, se obtendría una función de producción muy estática que sólo sería precisa para una cantidad de producción específica. Pero para la mayoría de los bienes intermedios no se conocerá la demanda antes del proceso de optimización y tampoco habría mucho que optimizar para el algoritmo porque no habría ninguna información sobre la elasticidad en el sistema. En el mejor de los casos, el solucionador podría determinar la viabilidad de todos los planes existentes, de forma similar a la planificación soviética del balance de materiales. Cualquier cambio en la producción obligaría a los productores a ajustar manualmente su función de producción al nuevo objetivo, lo que atascaría el proceso iterativo de planificación y pondría a prueba a los productores en su funcionamiento cotidiano. La mayoría de los productores se verían entonces obligados a proporcionar no una única función de producción, sino variantes para diferentes escenarios de demanda. Teniendo en cuenta el dinamismo de las economías reales, junto con el deseo de racionalizar el proceso de optimización, podría parecer que sería más beneficioso cuanto más granulares fueran estas funciones de producción, hasta un desglose de lo que se necesita para una unidad singular, con el fin de ampliarlas y reducirlas dinámicamente en función de la evolución de la demanda. De esta forma, Philipp Dapprich (2022: 7), por ejemplo, entiende la optimización como el simple proceso de identificar los escalares óptimos para determinar la intensidad para cada función de producción en la economía.20 Pero en la práctica esto será completamente inviable si no se realizan también ajustes manuales.

Las funciones de producción con menores tamaños de producción no sólo son más difíciles de componer, en lo que respecta a su elasticidad, sino que también conllevan el grave riesgo de distorsiones, ya que, por muy bien que se definan, no se pueden extrapolar a ciegas: La relación entre los insumos se alterará significativamente al cambiar los objetivos de producción, ya que con las economías de escala siempre nos enfrentaremos a no linealidades y a lo que en teoría de la optimización se denomina no convexidad. En el caso de nuestra fábrica de coches, serán necesarias inversiones importantes para producir el primer coche. Pero para fabricar diez mil vehículos, no será necesario ampliar la maquinaria de la fábrica en la misma medida, sino que sólo se necesitará más mano de obra y piezas. Pero incluso las necesidades de mano de obra no aumentarán linealmente en la mayoría de los casos. También con la multiplicación de ecuaciones insumo−producto simples, los productores asociados podrían enfrentarse a instrucciones irracionales, como la adición de un tercio de una cadena de montaje. Adicionalmente, esta fábrica de coches probablemente produciría más de un modelo, y cada modelo probablemente tendría diferentes especificaciones, lo que requeriría determinar la cuota de cada máquina, software de operación de negocios o cuenta de gastos generales correspondientes a cada uno de los diferentes métodos de producción. Y con cualquier cambio en el producto, esta proporción tendría que reordenarse de nuevo.

Por eso, para la construcción de un plan de un solo año, Cockshott propone separar una matriz de flujos de insumos directos, materias primas que se consumen inmediatamente, que podrían ampliarse y reducirse fácilmente, de “una matriz correspondiente del acervo de capital, que especifica la cantidad de máquina Y necesaria para producir un flujo anual P de producto x”,21 mientras que la producción neta para el período de planificación en curso se expresa como un vector objetivo. Con esta medida separa el consumo material lineal del capital circulante del no lineal del capital fijo. Pero es muy cuestionable que esto haga realmente justicia a la complejidad del problema. Otros planificadores óptimos demuestran una conciencia del problema mucho mayor y se están llevando a cabo investigaciones interesantes abordando estas cuestiones con la ayuda de la programación entera mixta y la linealización por partes para aproximarse a ellas (Härdin, 2021a; CibCom, 2022: 43-44), pero independientemente de la viabilidad de estas soluciones, esto significa que los productores necesitarían científicos de datos dentro de sus empresas o expertos externos que les ayudaran a modelizarlo. Otra opción sería utilizar la inteligencia artificial para elaborar estas funciones de producción sobre la base de diferentes variantes de la demanda. Sin embargo, con el estado actual de esta tecnología, es dudoso que se quiera confiar en tal alquimia para una parte tan crítica del proceso de planificación.

Así que, en lugar de limitarse a escalar los métodos de producción hacia arriba y hacia abajo, en realidad, un marco de planificación algorítmica exigirá una intromisión constante en estas funciones. Hacerlo con cierta precisión será un reto que no hay que subestimar. Ya el pensar en la tarea produce dolores de cabeza. Además, también es muy poco probable que todas las necesidades de producción, capital fijo, bienes intermedios y gastos generales necesarios para mantener una operación en funcionamiento puedan conocerse con todo detalle y en sus proporciones correctas desde el principio. En la mayoría de los casos, lo mejor que puede conseguirse es una aproximación, no muy diferente de la de una economía de mercado, ya que gran parte de este conocimiento sólo surgirá sobre la marcha, por lo que será necesario alterar dinámicamente estas funciones a lo largo de un periodo de planificación para añadir los insumos que faltan, que deberán añadirse proporcionalmente a cada método de producción al que contribuyan, lo que probablemente requiera a menudo una alteración de la relación entre coeficientes técnicos.

Esta tarea de Sísifo sería una compañera constante de todos los procesos de planificación a nivel de la empresa. Puede que algún insumo no esté disponible y haya que sustituirlo, que el desplome de la demanda de algunos productos altere los requisitos de producción, que algunos productores hayan olvidado introducir insumos críticos en la matriz de flujo o que alguna maquinaria se averíe antes de lo previsto. Todo ello requeriría un ajuste manual. En comparación con una economía de mercado, esto no significaría simplemente comprar un repuesto en el mercado, sino insertarlo en estas funciones de producción. Esto constituiría una carga considerable de trabajo administrativo que es sencillamente innecesario en un sistema de mercado, y vendría a añadirse a otros trabajos adicionales dentro de una economía socialista, como las reuniones del consejo, ya que no puede ser realizado a distancia por algunos gestores del departamento de planificación, sino que requiere la información del “hombre sobre el terreno” (Hayek, 1948: 83) implicado directamente en el proceso de producción. Teniendo esto en cuenta, los experimentos prácticos que pretenden probar la viabilidad de un marco de este tipo deberían centrarse menos en simulaciones técnicas y más en la formulación de funciones de producción para una variedad de procesos de producción con el fin de recibir información sobre su precisión, elasticidad y el tiempo necesario para describirlas.

Dinámica, incertidumbre y dominación social

De forma similar a la aproximación de las no linealidades con funciones lineales, un óptimo estático tendría que recalcularse constantemente para aproximarse al dinamismo de la economía. ¿Cuál sería el intervalo para tales ajustes? ¿Habría que bajar a horas, minutos o incluso segundos? Aquí existe una contradicción fundamental entre la necesidad de ajustar manualmente las funciones de producción que tienen lugar bajo un horizonte temporal humano y la necesidad de revisiones permanentes del plan calculadas con velocidad algorítmica. Los humanos no pueden seguir el ritmo de intervalos de tiempo más cortos, pero los más largos introducirán señales erróneas y un terrible retraso en la economía. También cabe preguntarse si una mera contracción de los intervalos de ajuste bastaría realmente para hacer frente a la naturaleza probabilística de las economías reales y a la incertidumbre que las incógnitas infunden en el sistema. Parece ser que el movimiento económico se simula aquí encadenando instantáneas momentáneas y vacilantes que, en cierta medida, seguirían siendo siempre especulativas.22

Este reto fundamental de volver a integrar la dimensión del tiempo en sus cálculos es otro grave problema al que tendría que enfrentarse un marco de planificación óptima de este tipo, que dará lugar a varios problemas consecuentes relacionados con la temporalidad de la asignación real.23 Como parte de los problemas que surgen al volver a relacionar el mapa estático con el territorio dinámico, la aplicación del modelo, el acto forzoso de imponerlo al mundo real, podría entenderse, por tanto, como el tercer aspecto del problema del conocimiento. Esto debería hacerse evidente al pensar en la desviación entre el modelo y la realidad material. Lo que calculan los solucionadores de optimización es un plan a un año que nunca será realmente óptimo debido a la inexactitud de la información económica. Pero, ¿qué puede significar para las decisiones de asignación sobre el terreno que, ante el dinamismo de la economía, haya que calcular un nuevo plan a un año cada dos por tres? Si existiera un cierto ritmo económico en forma de periodo de planificación anual, habría que tener en cuenta lo que ya se hubiera asignado durante el tiempo transcurrido, posiblemente restándolo de la nueva asignación anual calculada.

Aunque ya no nos encontremos con errores de agregación, seguimos teniendo que lidiar con el problema de lo que podríamos llamar el “desglose temporal de las asignaciones”. Para calcular una asignación óptima sería necesario determinar en qué momento del tiempo determinadas cantidades de bienes específicos estarán disponibles para su distribución. Esto también está relacionado con la cuestión esencial del orden en que serán provistos los distintos productores beneficiarios de la asignación anual. Dicho de otro modo: ¿quién recibe primero sus recursos y componentes? Esto parece pedir a gritos alguna entidad coordinadora que tenga que tomar tales decisiones de asignación, sopesando el riesgo de paros entre las diferentes industrias y empresas, si esta información no puede integrarse en el modelo. Mientras que la mayoría de los planificadores óptimos, como Cockshott o Dapprich, simplemente pasan por alto esta cuestión crítica del tiempo, las únicas soluciones que se han planteado hasta ahora para mitigar este problema es diferenciar aún más los productos “con respecto al periodo de tiempo durante el que se producen” (Kantorovich, 1976: 26), lo que aumenta significativamente el número de variables, y reduciendo el horizonte de planificación de un año a periodos de tiempo más cortos, como proponen Dave Zachariah y Loke Hagberg (2023) en su propuesta de planificación con horizonte decreciente, que de hecho era también la realidad en la planificación soviética, donde los planes trimestrales −no el plan anual− orquestaban la actividad económica sobre el terreno. Sin embargo, sigue existiendo una tensión fundamental entre el cumplimiento de los planes a corto plazo y la planificación de las inversiones a largo plazo: ¿optimizamos el cumplimiento del plan en el periodo actual o en algún momento del futuro? Si es lo primero, ¿cómo garantizar que los proyectos reciban los recursos necesarios en el presente si sólo empiezan a contribuir al cumplimiento del plan dentro de unos años? Al mismo tiempo, si se optimiza el cumplimiento del plan en el futuro, existe el grave riesgo de que se produzcan sobreinversiones y escasez de recursos en el presente.

Cualquier medida para hacer frente al dinamismo de la economía reintroducirá probablemente el problema soviético de la incertidumbre de la oferta para las empresas, que surgirá inevitablemente con las repetidas revisiones del plan, que Kornai (1994) consideraba uno de los aspectos más perjudiciales del sistema soviético. Las asignaciones ya concedidas podrían retirarse de nuevo en cualquier momento cuando parezca más óptimo para el motor analítico. No habría compromisos contractuales, sino sólo verdades determinadas algorítmicamente, que probablemente estarían en constante cambio, ya que aquí la elección es entre rigidez o incertidumbre. Por un lado, se aspira a que esos ajustes dinámicos reaccionen a los inevitables errores de planificación y a los cambios imprevisibles del sistema económico −una economía planificada está condenada a hacerlo a la luz de las limitaciones epistémicas y de la contingencia del mundo real−, mientras que, por otro lado, es muy probable que en ausencia de compromiso contractual resurja la misma tendencia observada en la Unión Soviética, en la que las empresas acaparaban componentes críticos por miedo a la escasez, lo que con sus acciones no hacían sino empeorar la situación de toda la economía, intensificando la escasez o incluso creándola en primer lugar.

En este caso, los intereses de los productores individuales están en contradicción con una asignación óptima de los escasos recursos de la economía en general, porque no se puede suponer simplemente que todos los agentes son actores racionales, que sacrificarán su propio interés en favor del bien común. Como en el sistema soviético, es posible que los productores no comuniquen la información económica con veracidad o intenten engañar al sistema. Así pues, no es sólo la capacidad epistémica de articular estas funciones de producción lo que podría ser un obstáculo para la realización de dicho marco de planificación óptima, sino también la voluntad de todos los participantes de hacerlo de buena fe. Por ejemplo, al exagerar drásticamente el riesgo de una parada de la producción o al inflar sus necesidades de insumos, los productores podrían aumentar en consecuencia la posibilidad de recibir la cantidad necesaria a tiempo en detrimento de los demás, lo que podría dar lugar a una espiral altamente disfuncional de costes inflados o de exigencia distorsionada si no se inhibe. Mediante la comparación de diferentes productores de la misma industria, un solucionador de optimización podría evitar las unidades de producción ineficientes, pero habría que tener cuidado de no reintroducir alguna forma de “compulsión muda” (Mau, 2023) con este tipo de medidas.

Otro problema crítico es que hay que tener en cuenta el comportamiento abiertamente malintencionado de los agentes, deseosos de sabotear este procedimiento de planificación, no importa si procede del interior de las empresas, o bien de algún actor extranjero deseoso de ver fracasar el sistema. Sin embargo, la cuestión más acuciante es la fragilidad de un modelo de este tipo. Este sistema tiene un único punto de fallo: si se infringe una sola restricción hay que recalcular todo el plan. Esto ni siquiera exige malas intenciones y ataques envenenados de datos, sino que podría ser el resultado de errores banales en la entrada de datos, como cuando se introduce un dígito dos veces por error. Todo esto exige algún tipo de superintendencia en la introducción de datos, lo que se hace aún más problemático con la actividad económica a pequeña escala. Conscientes de la dificultad de integrar todo esto en un marco de este tipo, la mayoría de los planificadores óptimos de hoy en día se alinean con la ortodoxia marxista de fusionar pequeñas empresas en entidades mayores, convertir restaurantes en comedores, organizar oficios dentro de cosechadoras, fusionar fábricas en conglomerados, etc., para socializar la producción con la esperanza de reducir los despidos administrativos y garantizar cierto control sobre sus acciones. Pero también existen deseconomías de escala; lo grande no siempre es hermoso. La actividad económica espontánea y a pequeña escala cumple funciones críticas en las sociedades capitalistas actuales. ¿Una economía socialista simplemente las suplantará? Si no es así, ¿cómo se pueden integrar y controlar sus planes?24

Esto lleva aparejado un grupo de preguntas sobre el grado de autonomía que tendrían realmente las unidades de producción, no sólo a la hora de fijar sus objetivos de producción, elegir sus insumos y determinar qué producir en primer lugar, sino también sobre cómo se las reconocería como tales. ¿Cómo se forman las unidades de producción? ¿A través de qué proceso se acreditan? ¿Tiene cualquier lugar de trabajo acceso inmediato a todos los bienes, o existen puertas burocráticas, en las que alguna entidad coordinadora superior debe desbloquear primero un artículo antes de que pueda insertarse en una función de producción? ¿Pueden las empresas introducir directamente sus necesidades o tiene que confirmarlas un superior? Independientemente de su oposición a los esquemas de programación lineal, la concepción de Stafford Beer de un “sistema viable” (Beer, 1981) sugeriría aquí algún tipo de reconciliación entre descentralización y centralización. Aunque la experiencia soviética ha demostrado que un cierto grado de autonomía de la periferia es deseable, tendría que equilibrarse cuidadosamente en un marco de planificación algorítmica de este tipo, ya que sin ninguna instancia de control en forma de juntas de coordinación legitimadas democráticamente para sectores, industrias o regiones, sería simplemente demasiado frágil y sería demasiado fácil explotar un algoritmo de optimización de este tipo para asegurarse una ventaja injusta en la asignación o sabotear directamente el procedimiento de planificación añadiendo coeficientes técnicos extravagantes para los que el algoritmo no encontraría una solución viable. Por supuesto, podría introducirse un sistema de control técnico para detectar estos errores, pero seguiría siendo necesaria la supervisión humana en forma de algún tipo de institución, compuesta por burócratas o delegados, como quiera que se les llame.

¿Podrían las juntas de coordinación de delegados cumplir esta función de forma democrática? ¿O nos enfrentamos más bien a la amenaza de la burocratización y la reaparición de una clase coordinadora de nivel medio a cargo del control de las empresas, lo que daría lugar a un juego de vigilancia del gato y el ratón que es caldo de cultivo para el nepotismo y otras formas de abuso de poder? Incluso cuando estas juntas de coordinación fueran elegidas democráticamente y pudieran ser revocadas por decisión mayoritaria, los funcionarios se encontrarían en una posición en la que los actores bien establecidos tendrían mucho control sobre las industrias y podrían mantener alejados a otros, que podrían desear perturbarla introduciendo la destrucción creativa, o podrían defender demandas inapropiadas en apoyo de su industria o región en detrimento de otras. Crear otra instancia de control para apelar contra las decisiones de una junta de coordinación potencialmente corrupta podría ser sin duda una posible solución, pero aquí volvemos a encontrarnos con problemas temporales. Para mantener la economía en funcionamiento, no habría tiempo para largos debates deliberativos y orientados al consenso, pero la urgencia económica exigiría decisiones rápidas de estos consejos y otras instancias de control, si se quiere evitar que la economía se paralice. Probablemente, el miedo a la parálisis horizontalista erosionaría gradualmente cualquier estructura democrática radical de estas instituciones y podría convertir todo el aparato en una máquina burocrática, no muy diferente del papado de la planificación dirigida soviética.

Una solución más elegante a este problema sería idear un sistema de incentivos que recompensara a los productores por presentar información veraz, alineando así los intereses particulares con el bien común. El sistema soviético no logró articular algo así. Como ya se ha dicho, los indicadores de objetivos eran en muchos casos contraproducentes, contradictorios y la causa de muchas de las ineficiencias de la economía. Hasta ahora no se ha descubierto ninguna fórmula que cure totalmente estos males. Sin embargo, más recientemente David Laibman ha llevado a cabo una interesante investigación sobre el replanteamiento de dichos indicadores, desarrollando el esbozo de una posible medida del rendimiento en una economía socialista (Laibman, 2015: 317-323), que incluye una “tasa de comparación” junto con medidas de rendimiento cualitativas y sociales, basadas en las normas de la industria o en la historia de la empresa, que incentivarían a los grupos de trabajadores a utilizar los recursos de forma más eficiente. Al proporcionar información inflada sobre las necesidades de insumos, se reduciría la medida del rendimiento de los productores. Aunque se trata sin duda de un incentivo para proporcionar información adecuada, es dudoso que esto resuelva realmente la necesidad de un control central sobre la introducción de datos y elimine por completo la tentación de exagerar la urgencia de las propias demandas productivas. La información falsa, proporcionada voluntariamente o no, sigue siendo el talón de Aquiles de cualquier sistema económico de este tipo. Sin embargo, este problema no es exclusivo de la planificación óptima realizada mediante algoritmos, sino también de otros marcos de planificación basados en la negociación deliberativa. Sólo cuando las empresas son realmente independientes y la asignación se realiza mediante un racionamiento por precios no se tropieza con este problema, pero entonces la mano invisible del mercado vuelve a tomar las riendas con todos sus devastadores efectos secundarios y ya no se puede hablar de una administración racional de la economía a la luz del colapso ecológico, pues sólo la rentabilidad de las empresas determinará la asignación de los escasos recursos.

¿Hacia una jerarquía de fines?

Junto al reto de componer y administrar un sistema global de funciones de producción, surge otro grave problema al interconectar el objetivo del plan con el propio proceso de optimización. En todos los modelos de planificación óptima, la demanda final de bienes de consumo −es decir, el objetivo del plan de necesidades colectivas− se expresa formalmente como un vector objetivo. Quienes no estén familiarizados con la jerga matemática pueden pensar en el vector objetivo como una lista que representa las necesidades cuantificadas de la sociedad o la demanda prevista de todos los bienes de consumo. Esta lista engloba todos los bienes privados y públicos que una sociedad desea producir durante un periodo de planificación determinado. Como ya se ha indicado anteriormente, el procedimiento de optimización no significa otra cosa que el mejor cumplimiento de este objetivo de planificación con unas restricciones dadas, o dicho de otro modo, identificar el conjunto de planes de producción individuales que se desvíe lo menos posible de este objetivo ideal por el lado del consumo. Así pues, antes de iniciar el proceso de optimización, la sociedad tiene que averiguar qué desea para el próximo periodo de planificación. Pero, ¿cómo puede concebirse esta lista? En la mayoría de los casos, podría ser conveniente utilizar el estado estadístico de la técnica para la determinación cuantitativa de las necesidades futuras en lugar de pedir a los consumidores que expongan sus necesidades previstas en forma de listas de deseos; en otros casos, no habrá forma de evitar los pedidos de los clientes o los procedimientos de planificación deliberativa, en forma de presupuestos participativos a nivel municipal, por ejemplo, o un referéndum en relación con la transición energética y las inversiones posteriores. El autor ya ha abordado este reto del registro de necesidades conceptualizándolo como un problema de previsión (Grünberg, 2023).25

Sin embargo, en un marco de planificación óptima existe la necesidad de clasificar la urgencia de las necesidades sociales que, de algún modo, se integrarían en un proceso de optimización algorítmica propiamente dicho.26 Este problema surge bajo la premisa de que la sociedad probablemente deseará más de lo que es capaz de producir, sobre todo en lo que respecta a la catástrofe ecológica que se avecina en el horizonte. El hormigón utilizado para los cimientos de los aerogeneradores podría faltar para la construcción de nuevas escuelas, oficinas o fábricas. Mientras no nos reeduquemos, el deseo humano superará nuestro aparato productivo, así como la capacidad de carga de nuestro planeta, y también en una economía socialista seguiría siendo necesario negociar sobre el uso de los escasos recursos entre fines contrapuestos.